监委会如何述职

本文围绕监委会述职展开,从核心框架、合规基础、量化模块、国内外实践差异、风险规避和长效机制六大维度,系统讲解监委会述职的实操方法,提出构建“履职-问题-改进”的闭环述职框架,强调用量化指标提升述职说服力,帮助监委会完成合规且高效的述职工作。

Joshua Lee

Joshua Lee- 2026-01-21

人工智能如何变聪明人类

文章回答了人工智能如何变得比人类更聪明的路径:通过规模化与架构创新、多模态与检索增强、神经符号推理与世界模型,以及工具调用与具身学习提升推理与规划能力;同时以安全评估、合规治理和人机协作保证可控可用;并指出幻觉、数据质量与能耗等瓶颈与风险,提出阶段性路线图与未来趋势,强调增强人类智能的最终目标。

Rhett Bai

Rhett Bai- 2026-01-17

如何对人工智能进行监管

监管人工智能的有效路径是以风险分级为核心,通过制度与技术双轮驱动实现透明、可解释与可追责的治理闭环;具体做法包括建立全生命周期台账和模型卡、开展红队测试与输出过滤、设置用户告知与申诉机制、以RACI明确问责、引入NIST与ISO等标准组合并对齐欧盟与中国框架,同时以指标化与透明度报告实现持续监控与审计;在跨境运营中采用母框架+本地差异策略,并前瞻布局基础模型、算力与内容标识等新议题以稳妥兼顾创新与安全。

Elara

Elara- 2026-01-17

人工智能如何进行管理

本文系统阐述人工智能管理的体系化方法:以业务目标与风险阈值为牵引,建立分级治理与全生命周期流程,融合MLOps与AIOps实现端到端可追溯、可审计与可度量;通过透明度、可解释性、隐私与内容安全等控制点构建风险与合规闭环;以KPI、SLA与模型健康指标驱动持续改进与成本优化;结合国内与国外平台优势进行选型与能力补齐;并展望多模态、代理式AI、来源溯源与绿色推理等趋势,强调在NIST与行业TRiSM框架指导下形成可被审计的治理语言,确保规模化、稳健与可持续的AI价值产出。

Joshua Lee

Joshua Lee- 2026-01-17

人类如何给人工智能赋权

给人工智能赋权的关键是以可控自治为核心,通过最小权限与策略即代码逐级授权,配套可观测、可逆与可审计的工程与流程护栏,并以业务KPI、模型质量与合规指标三位一体持续评估;在人机协作中设置阈值与兜底,将数据、工具与环境的能力供给和红队化安全评测结合,分阶段从工具到代理推进,确保价值与风险在同一闭环内动态平衡。

William Gu

William Gu- 2026-01-17

人工智能如何建立价值观

文章提出以多层防线与闭环治理让AI建立价值观:通过价值发现与规则固化,将社会、法律与组织价值转译为数据与目标;以SFT、RLHF/RLAIF和宪法式AI建立内生偏好,叠加护栏与权限治理控制外部行为;依托NIST与Gartner框架搭建端到端治理与评测体系;最终以平台化编排、红队常态化和线上观测持续迭代,实现可审计、可回滚的价值对齐工程。

Rhett Bai

Rhett Bai- 2026-01-17

如何监督管理人工智能

本文系统阐述了以风险为导向的人工智能监督治理方法,强调以可解释性、可追溯与持续监控为核心,通过三道防线组织模型、政策与工具协同,建立从数据到部署的端到端控制闭环。文章结合NIST AI RMF与Gartner AI TRiSM的实践,提出政策—标准—流程—记录的工程化体系,辅以评测与审计、跨境与行业合规映射、开源与商用工具组合,并给出分阶段落地路线图与可量化KPI,以在不抑制创新的前提下降低伦理、合规与运营风险,提升可信度与业务ROI。

William Gu

William Gu- 2026-01-17

人工智能如何监管与应对

文章系统阐述了以风险为导向的人工智能治理路径,提出“策略-流程-技术-度量”闭环,结合欧盟AI法案与NIST框架的实践方法,围绕分级分类、全生命周期合规、模型评估与运行时监控、红队与可解释性、供应链管理与水印溯源等关键手段,为金融、医疗、公共部门与平台场景提供落地要点与门禁策略;并预测从合规清单走向可信度量、自适应监管与生成式AI专章的趋势。

William Gu

William Gu- 2026-01-17

如何防止人工智能的普及

本文提出以风险分级与许可准入为核心的多层治理路径来防止人工智能的无序普及,通过算力治理、模型发布管理、平台端API与内容安全等技术与产品手段,配合企业合规与社会教育,形成“减缓扩散速度、缩小可得范围、降低误用概率、提升问责能力”的综合策略;同时强调国际协作与跨境管制,建立透明标准与审查机制,并以分阶段路线图与量化KPI持续迭代,确保高风险能力在可控、合规的边界内稳态落地,从而实现有序、负责任的扩散管理。

Elara

Elara- 2026-01-17

如何选择人工智能技术

选择人工智能技术应以业务结果为导向,从问题类型与数据条件出发匹配模型与工程栈,并以可量化指标验证价值。关键在于明确目标与约束,优先采用成熟框架与可移植方案,结合云与边缘的混合部署以平衡性能、合规与成本。通过数据治理、MLOps/LLMOps与风险管理建立可审计、可回滚的生命周期,降低锁定与治理成本。对生成式AI,以RAG与本地化策略控制幻觉与隐私风险,分阶段试点并持续优化ROI,最终实现稳定、可持续的AI落地。

Rhett Bai

Rhett Bai- 2026-01-17

如何引导人工智能发展

要系统性引导人工智能发展,应以人为本与风险导向为核心,构建多层级治理体系与生命周期度量,部署红队测试、可解释与统一评测基准,完善数据主权与隐私合规,并选择具备治理与审计能力的平台与开源生态。通过国际标准对齐与监管沙盒试点,形成“策略—流程—工具—评估—改进”的闭环,使创新、安全与普惠在同一框架内协同推进。

Elara

Elara- 2026-01-17

如何测试人工智能强度

本文提出以能力、鲁棒性、安全、效率与人类满意度为核心的多维评估体系,结合标准化基准、红队对抗与线上A/B实验,确保指标可量化、过程可复现与结果可审计;并引入NIST治理框架与企业实践,将评测与模型生命周期打通,强调跨语种与多模态通用性、系统视角与真实业务闭环,最终以场景化与负责任评估提升人工智能强度与生产可用性。

William Gu

William Gu- 2026-01-17

如何控制人工智能发展

文章提出以以人为本、风险分级与技术制度并进为核心的AI治理路径,强调通过动态许可、标准认证、评估审计与工程化控制,实现“看得见、控得住、追得上”的发展控制。文中构建制度工具与技术手段的组合框架,涵盖数据治理、行为对齐、接口节流、内容溯源与算力治理,并给出组织三道防线与指标化落地方法,同时展望评估场景化、治理自动化与国际协同等趋势。

William Gu

William Gu- 2026-01-17

如何合理控制人工智能

本文提出以风险分级与分层治理为主轴的人工智能控制方法,在数据、模型、应用与用户四层建立策略引擎、内容审核、监控审计与应急机制,结合最小权限、透明可解释与红队评估实现可验证的安全与合规;在高风险场景采用隔离、限速与兜底开关,低风险场景保持效率与创新;通过政策即代码与供应商风险管理形成端到端治理闭环,并预判多智能体与隐私计算将推动治理工具与监管协同的加速成熟。

Joshua Lee

Joshua Lee- 2026-01-17

人工智能准则如何实施

要实施人工智能准则,需要将公平、透明、可解释、隐私与安全等原则系统化为治理框架与流程控制,并以量化指标、文档与审计保障执行。核心做法包括建立跨部门AI治理委员会与RACI分工,在数据与模型全生命周期嵌入风险分级、评估与监控,上线审批与变更管理确保问责与可追溯,选择具备访问控制、审计与内容安全能力的平台与工具,结合国际框架进行度量与改进,同时强化法律合规、数据主权与培训红队演练,形成试点到规模化的闭环治理。

Rhett Bai

Rhett Bai- 2026-01-17

人工智能如何对抗人类

本文从“目标错位、滥用与系统耦合”三大根因出发,阐明人工智能并非天然敌对,但在失配与误用下会产生对抗性后果;应以价值对齐为核心,构建“技术防线—组织治理—法规合规—应急演练”立体防护。通过对齐与守护式推理、红队评测与持续监控、隔离与最小权限、内容溯源与人在环等手段,将风险可度量、可审计、可关停。结合NIST、OECD与欧盟AI法案等框架,落实风险分级与合规证据链,配合国内法规完善数据与内容治理。面向未来,多模态与代理系统将提升能力与风险并存,监管趋向精细化与跨境协作,企业需前置合规与工程化安全,将安全从“约束”转化为“质量与信任”的核心竞争力。

Joshua Lee

Joshua Lee- 2026-01-17

如何更好发展人工智能

本文提出以“战略—治理—基础设施—人才—场景—安全—评估”的闭环推动人工智能发展,核心是在负责任AI原则下明确目标与边界,夯实算力与数据基础,通过云边协同与开源生态提升效率与成本表现;在模型层面以场景驱动选择与训练大模型,强化可解释性与鲁棒性,并以隐私计算与合规实现跨域协作;产业落地方面以ROI为导向进行场景优先级排序,推动从项目到平台的产品化与商业模式创新,结合GEO策略实现本地化与全球扩展;通过红队评测与度量体系保障安全与价值可见,采用试点、灰度与A/B测试形成持续迭代机制。未来多模态、边缘AI与检索增强将成为主流,治理与评估平台配套化,企业需以指标与合规为双轮,走向规模化与可持续。

Rhett Bai

Rhett Bai- 2026-01-17

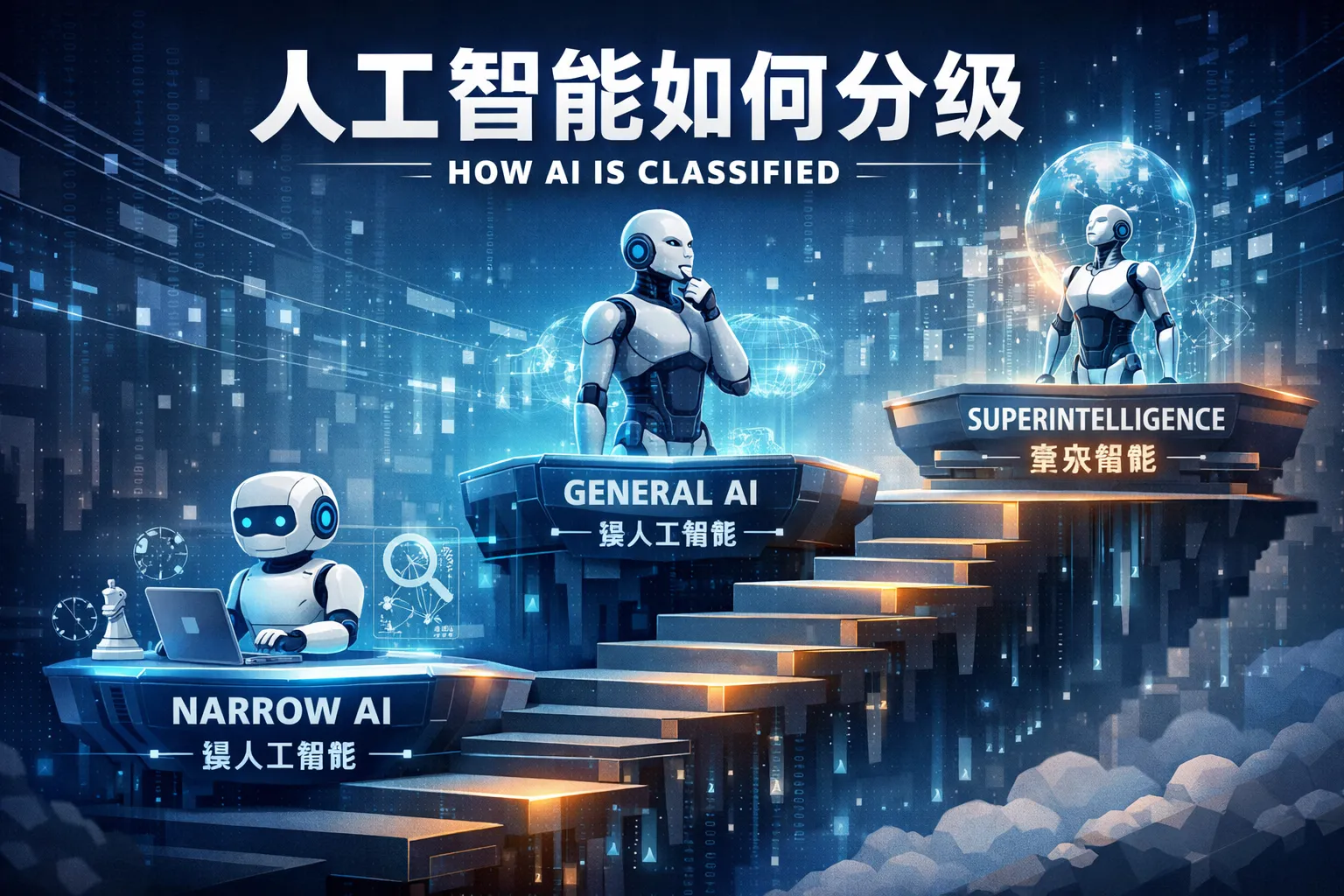

人工智能如何分级

人工智能分级应从“能力、风险、场景与治理要求”四维度统一度量:能力看推理、多模态与工具调用,风险看影响严重性与可控性,场景看业务关键性与监管强度,治理则映射为人类在环、审计与权限控制。以矩阵化方式将模型能力等级与风险分级交叉,形成差异化控制与合规清单;低风险快速放行,中风险加强监测,高风险必须人类在环并强审计,不可接受风险禁止。分级需动态更新,随模型与数据变化持续评估与再分级,实现可持续、安全的AI规模化落地。

Elara

Elara- 2026-01-17

低代码引擎哪个最好使

低代码引擎并无单一最好使的答案,关键是匹配业务场景与技术边界;通过业务画像、合规治理、扩展架构、部署策略与成本效率的框架评估,并进行试点验证更可靠。国内平台在合规与本地生态适配有优势,如网易 CodeWave具备全栈可视化、源码可导出与多云部署的灵活性;海外平台在全球化与生态成熟度方面突出,如Power Apps、Mendix与OutSystems。未来,AI赋能、可观测性与FinOps将进一步提升低代码平台的易用性与经济性。

Joshua Lee

Joshua Lee- 2025-12-24

低代码带来的混乱有哪些

低代码常见的混乱包括应用蔓延与重复建设、数据碎片与口径不一致、集成债务堆积、权限与合规漂移以及版本与生命周期治理失序。解决之道是以治理框架、企业架构与数据策略为基础,建立可观测性与审计闭环,并以具备统一目录、API契约管理、环境隔离、策略即代码与源码导出能力的低代码平台落地。通过融合团队、RACI职责、固定发布节奏与量化指标驱动的持续改进,可在保障速度的同时重塑秩序,实现可靠ROI与合规运营。

Rhett Bai

Rhett Bai- 2025-12-24