Java 如何调用keras模型

这篇文章系统讲解了Java调用Keras模型的全流程,涵盖前置环境准备、模型格式转换规范、主流调用方案对比、企业级部署优化以及合规避坑指南,通过引用权威行业报告数据和格式对比表格,指出SavedModel格式是Java生态中兼容性最优的Keras模型部署格式,同时给出了具体的调用步骤和优化技巧,帮助开发者搭建稳定高效的生产级调用链路。

Joshua Lee

Joshua Lee- 2026-02-06

如何减少大模型参数

本文系统回答如何减少大模型参数:以结构化剪枝和稀疏化做“真减法”,以PTQ/QAT量化降低存储与带宽,以知识蒸馏与低秩分解在小模型上重现大模型能力,并通过MoE、词表精简、权重共享与NAS实现架构级参数减法。工程上遵循低风险到高收益的组合策略,配合代表性校准与多维评测,逐步在不显著牺牲精度的前提下,实现参数量与推理成本的成倍下降。未来FP8/INT4、结构化稀疏原生加速与“可压即训”的训练范式将成为主流方向。

Joshua Lee

Joshua Lee- 2026-01-16

如何用python加入残差单元

残差单元是一种通过捷径连接提升深层神经网络性能的重要结构,能够缓解梯度消失并加快训练收敛速度。Python配合PyTorch或TensorFlow能够高效构建残差模块,并支持通道匹配优化。在图像分类、语音识别和自然语言处理等多种任务中残差结构表现优异,同时搭配协作化的研发项目管理系统可显著提升团队开发效率。未来残差结构将向更复杂的多分支与跨模态方向发展,并与自动化架构搜索结合进一步优化模型性能。

Rhett Bai

Rhett Bai- 2026-01-14

如何识别动物并框选python

在Python中实现动物识别与框选,主要依靠目标检测技术,将分类与定位结合,并输出边界框与类别标签。深度学习方法如YOLO、Faster R-CNN在多类别和复杂背景下有较高准确率,流程包括数据收集与标注、模型加载与推理、利用OpenCV绘制边界框。不同方法在成本、精度与适用场景上各有优劣。结合高质量数据、适宜算法和项目管理工具,可以高效构建适合多场景的动物识别系统,未来将呈现轻量化、多模态和自监督等趋势。

Joshua Lee

Joshua Lee- 2026-01-14

python如何向模型里添加内容

Python 向模型添加内容的核心方法包括数据扩充、增量训练、结构修改、特征引入及迁移学习,这些方式分别在适用范围、实现难度和性能影响上有不同特性。实践中需结合业务需求与技术条件,选择性使用增量训练以节省资源,迁移学习与结构优化可提升表达能力,而特征扩展则在不改变结构的前提下强化预测效果。在团队协作中配合版本管理与自动化评估可确保迭代的可追溯性与稳定性,未来趋势将更强调灵活更新与跨领域适配。

Rhett Bai

Rhett Bai- 2026-01-14

如何用python进行多标签分类

本文系统阐述了用Python开展多标签分类的完整路径:明确任务与标签结构,采用MultiLabelBinarizer等编码;在scikit-learn的One-vs-Rest、PyTorch/Keras的sigmoid多输出或Transformers文本模型中择优建模;以micro/macro F1、Hamming Loss等指标评估并进行每标签阈值调优;最终通过MLOps管线化部署与监控,实现准确性与工程稳定性的统一。

Joshua Lee

Joshua Lee- 2026-01-13

python如何将向量转置

本文系统阐明了在 Python 中“向量转置”的实质是维度管理:一维向量的转置在 NumPy、PyTorch、TensorFlow 中均不会生效,需先扩维为二维再转置;NumPy 可用 reshape/newaxis,PyTorch 用 unsqueeze,TensorFlow 用 expand_dims。文中给出方法对比表、复数共轭转置与性能要点,并提供在数据分析与深度学习场景的实战策略与规范化建议。

Rhett Bai

Rhett Bai- 2026-01-13

python如何输入连个特征图

本文系统阐述在Python中输入两个特征图的可行路径与工程要点:先统一通道顺序与批次维,再用插值、填充和1×1卷积对齐空间与通道,随后选择合适的融合策略(如concat、add、mul或门控/注意力)。文中给出PyTorch与Keras的可直接运行示例与常见陷阱,提供一张融合方式对比表,强调“先对齐、后融合、再压缩”的实践框架,并给出测试、可视化与性能优化建议以及面向多模态的未来趋势。

Elara

Elara- 2026-01-13

python如何识别目标图形

用 Python 识别目标图形可走两条路线:传统图像处理与深度学习。前者借助阈值、边缘、轮廓、霍夫与模板匹配,适合形状稳定与背景简单;后者通过检测与分割应对复杂光照、遮挡与多类别。核心步骤是明确任务输出、做好预处理与数据标注、选择合适模型与指标、并以部署与监控闭环持续迭代。通过迁移学习与推理优化(ONNX/TensorRT),在 CPU/GPU 或边缘端均可达成高精度与低延迟的平衡。

Rhett Bai

Rhett Bai- 2026-01-13

python如何指定多个gpu

本文系统阐述在Python中指定多个GPU的实操路径:小规模同机多卡可用CUDA_VISIBLE_DEVICES快速限定可见设备;训练任务在PyTorch中建议采用DistributedDataParallel,TensorFlow使用MirroredStrategy并配合set_visible_devices与逻辑设备;多机多卡需正确配置NCCL、进程拓扑与网络带宽,并以基线→扩卡→跨机的增量方式验证。结合nvidia-smi与Profiler构建可观测性,通过批大小、梯度累积、混合精度与数据管线优化提升吞吐;团队可在项目协作系统记录GPU配额与实验元数据,提升资源利用与复盘效率。未来在NCCL、编译器与云原生调度加持下,多卡并行将更自动化与高效。

Rhett Bai

Rhett Bai- 2026-01-06

python常数填充如何使用

本文系统解答了在Python中如何使用常数填充:以固定值统一数组、张量与序列形状,并控制卷积与边界条件。文中给出列表、NumPy与pandas的填充要点,以及PyTorch与TensorFlow在训练推理中的pad接口与维度顺序规则,配合图像、NLP与时间序列的实战示例。核心实践包括:一次性批量处理、预分配大壳减少拷贝、匹配dtype与设备、以mask隔离填充区域,并以数据契约记录填充值语义。结合工程协作和测试基线,可在保证性能与可解释性的前提下稳定落地常数填充策略。

Elara

Elara- 2026-01-06

python如何提取图像特征

本文系统阐述在Python中提取图像特征的路径:使用OpenCV与scikit-image实现传统局部与全局特征(如ORB、HOG),用PyTorch/TensorFlow提取CNN嵌入,并按预处理、检测/描述、表示到索引/匹配的流程组织;通过度量与可视化评估鲁棒性,结合两阶段策略实现高效检索与定位,同时提供代码示例与优化建议,兼顾精度与性能、工程与部署。

William Gu

William Gu- 2026-01-06

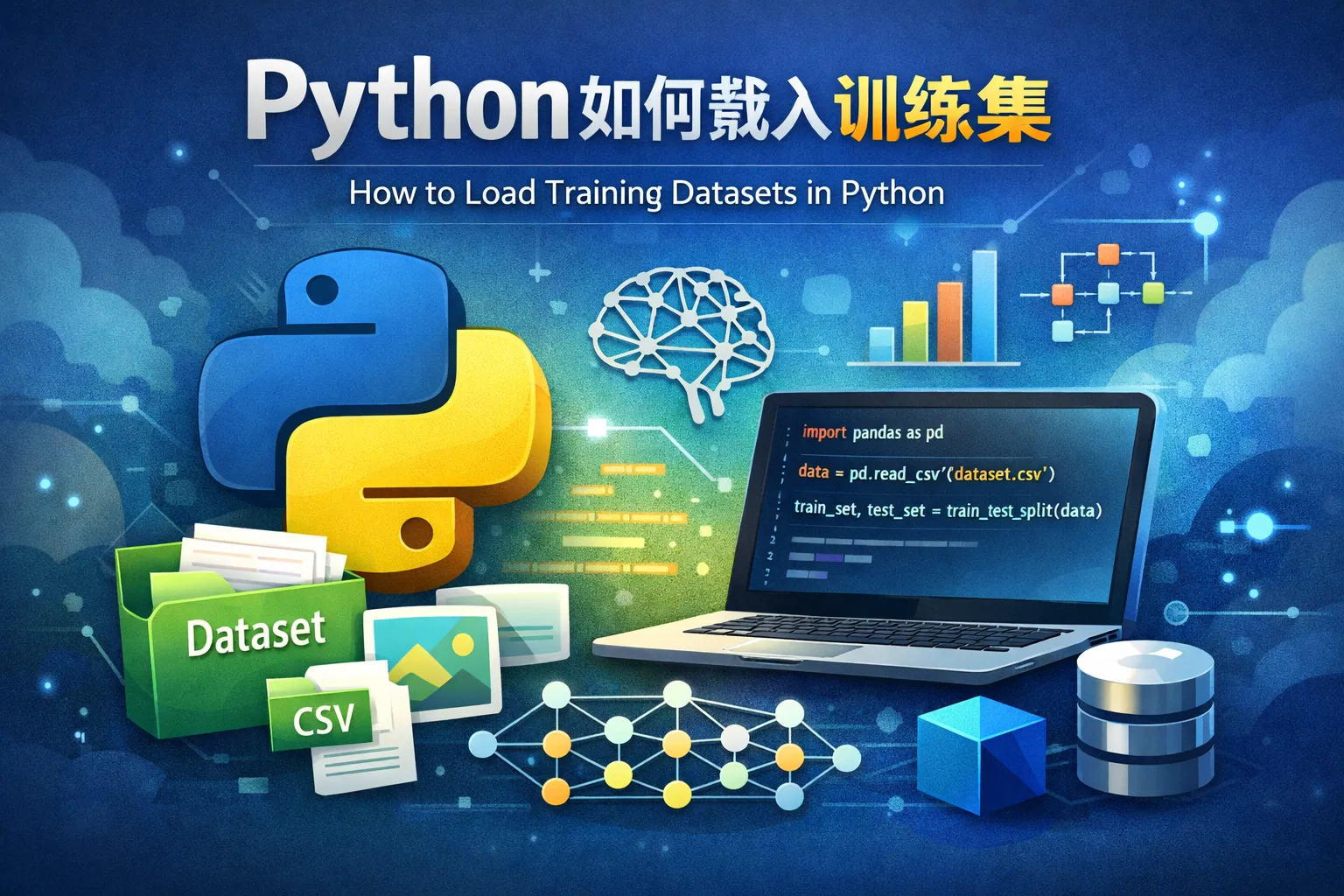

python如何载入训练集

本文系统回答“Python如何载入训练集”:结构化数据用Pandas/Parquet清洗与分块并行,深度学习任务用PyTorch DataLoader或TensorFlow tf.data构建高吞吐管道;在云端场景采用分片、缓存与对象存储直读,并将预处理与质量校验管道化。通过版本控制与协作系统保障可审计与复用,在需要的工作流中可接入PingCode跟踪研发过程。未来将以标准化格式、自动调优与流式训练为主。

Elara

Elara- 2026-01-06

python如何导入rnn模块

在Python中导入RNN模块可依据所用框架选择路径:PyTorch使用torch.nn中的RNN/LSTM/GRU,TensorFlow/Keras使用tensorflow.keras.layers中的SimpleRNN/LSTM/GRU,JAX则借助Flax或Haiku的RNN Cell。确保通过虚拟环境正确安装与匹配版本,然后以from ... import ...执行导入,并配合CI冒烟测试与文档规范提升稳定性与可复现性。

Joshua Lee

Joshua Lee- 2026-01-05

python如何用gpu训练

本文系统解答了Python如何用GPU训练:先搭建匹配的驱动、CUDA与cuDNN,并用conda或容器固定环境,再在PyTorch/TensorFlow/JAX中将模型与数据迁移到GPU、启用混合精度与高效数据管线。通过DataLoader或tf.data减少IO瓶颈,借助AMP与梯度累积缓解显存压力;扩展阶段采用DDP与NCCL进行多GPU分布式训练,并用Profiler定位热点。生产落地要重视可重复、可观测与协作,可将训练任务纳入项目协作系统(如PingCode)形成闭环。按“先正确、再加速、后扩展”的节奏推进,能稳步获得吞吐与收敛的双提升。

William Gu

William Gu- 2026-01-05

mxnet如何执行python

本文阐明在 MXNet 中 Python 仅是前端描述与控制层,核心数值计算由 C++/CUDA 后端异步完成并由引擎调度依赖与内存;开发者可在命令式、符号式与混合模式之间取舍,通过 Gluon 的 hybridize 把命令式代码固化为计算图,在保持灵活性的同时获取接近图执行的性能与可部署性。实践上需正确安装匹配的二进制、合理设置设备上下文、用显式同步确保测时与调试准确,并通过数据管道与内存复用降低开销;在工程落地中,结合指标基线、CI/CD 与项目协作工具提升从训练到推理的交付效率与可观测性。趋势上,Python 前端与后端加速将长期共存,自动混合与按需编译会增强跨硬件与部署能力。

Joshua Lee

Joshua Lee- 2026-01-05

python如何训练

本文系统解答“python如何训练”:以业务指标明确训练目标,使用Conda/Docker构建可复现环境,规范数据清洗与版本管理,依据任务选择合适框架(scikit-learn、PyTorch、TensorFlow),通过配置化代码架构与实验管理提升可维护性,结合混合精度、分布式与超参搜索实现训练加速,并在MLOps体系下完成评估、注册、部署与持续监控。文中引用Gartner(2024)与NVIDIA(2023)强调从研究到生产的工程化要点,建议在跨团队协作中适度引入项目管理系统(如PingCode)保障节奏与质量。

Joshua Lee

Joshua Lee- 2026-01-05