人工智能测试如何得高分

本文给出在人工智能测试中获得高分的系统方法:以业务对齐的多维指标与权重定义“高分”,用高质量金标与对抗样本保证覆盖度,通过离线基准+在线A/B的闭环持续优化;同时将安全、合规与成本纳入综合评分,以工程化工具链与人机混合评审提升可重复性与语义一致性;最终依靠组织治理与可观测性使“高分”可持续与可审计。

William Gu

William Gu- 2026-01-17

如何测试人工智能智障能力

本文系统阐述了如何以中性、专业的方法测试人工智能的失效与鲁棒性:先明确术语与任务边界,建立质量-风险-效率三维指标(如正确率、幻觉率、安全违规率、延迟与成本),再结合静态基准、动态评测与对抗红队形成闭环;通过场景化用例与分层语料保障贴近业务,用“人工+模型评审”提高评测效率与一致性;在跨模型对比中统一实验条件并采用多模型编排优化SLA与预算;借助开源与商用工具构建可重复与可审计的测试流水线,并依据NIST与Gartner框架落地治理与持续监控。最终以可观察、可量化、可回归的工程化能力,持续降低幻觉与风险,提升稳定性与用户体验。

Rhett Bai

Rhett Bai- 2026-01-17

人工智能如何通过测试

要让人工智能通过测试,需以可度量的质量标准覆盖数据、模型与系统三层,并以风险分级与合规作为底线。实践路径包括明确验收指标、自动化与对比实验、生成式事实性与安全对齐测试、系统级性能与鲁棒性验证,以及上线后监控与反馈闭环。结合NIST与Gartner的风险框架,将信任、风险与安全嵌入MLOps治理,使测试从一次性验收转为持续优化与可追踪的质量保障。

Joshua Lee

Joshua Lee- 2026-01-17

软件测试如何转大模型

本文系统给出软件测试转向大模型的路线:识别可迁移质量思维,补齐提示工程与评测方法,构建持续评测流水线与安全红队,选择评测、数据质量、MLOps或应用QA等细分方向,以端到端项目与作品集验证能力,并将合规治理嵌入上线闸门;依据多维指标建立质量基线与监控闭环,结合国内平台的合规与数据驻留优势、国外平台的生态成熟度实现多云策略,最终让生成式AI实现可控、可信、可用的工程化落地。

Elara

Elara- 2026-01-16

项目管理系统迁移验收标准怎么定才不留隐患

要避免项目管理系统迁移后的隐患,需以场景为主线构建可量化、可追溯、可回退的验收体系,覆盖数据完整性与一致性、权限流程与体验、性能与可用性、安全合规、集成联调与回退、组织采纳与度量等七大维度,并通过阶段化门禁、明确阈值与验收证据、灰度与应急演练来放行上线。引入可观测性与治理机制,结合工具化协作与标准化脚本,迁移上线即稳定;同时关注AI与策略即代码等趋势,持续提升验收效率与质量保障能力。===

William Gu

William Gu- 2026-01-16

项目管理系统迁移验收标准怎么定才不留隐患

文章提出以数据完整性、性能与连续性、安全合规、流程与SLA四大维度制定可度量、可追溯的迁移验收标准,通过阶段门治理、量化阈值与证据留存来降低隐患;强调RTO/RPO、P95/P99、越权阻断与UAT通过率等关键指标,并用对比表落地执行;同时将回滚与演练纳入验收红线,强化权限、审计与隐私验证;最后建议把验收清单与证据沉淀在协作平台中,并展望自动化验收与AI辅助对账的趋势,实现迁移后长期稳定与可治理。

Joshua Lee

Joshua Lee- 2026-01-16

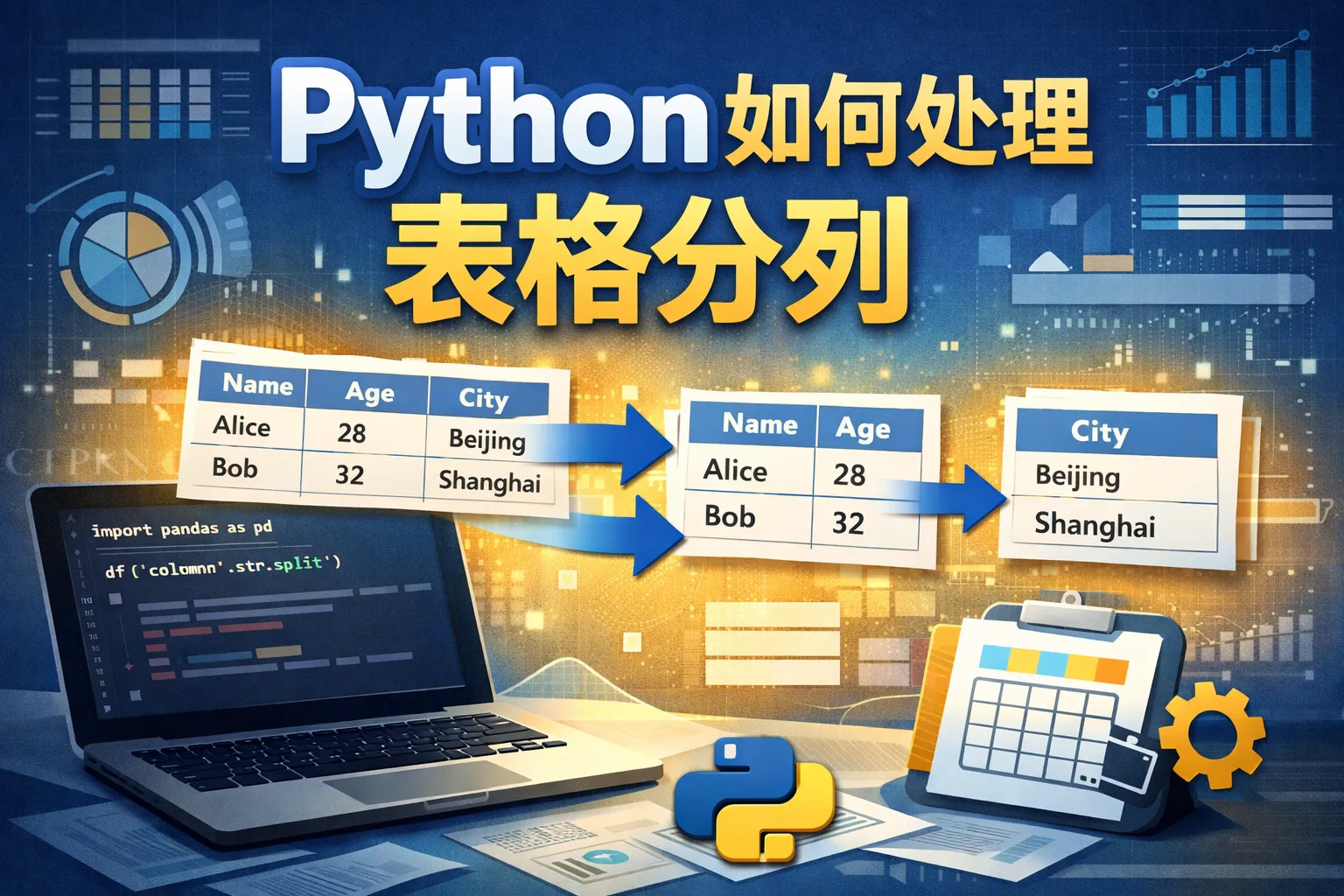

python如何处理表格分列

本文系统阐释Python处理表格分列的思路与落地路径,围绕分隔符、固定宽度与正则三大方法,结合pandas与Polars在CSV、TSV、Excel等多源数据中的向量化拆分实践,强调读取策略、性能优化与数据质量治理的关键性,并提供复杂场景(合并单元格、嵌套JSON、跨行文本)的应对方案与工程化流水线建议。文中给出工具对比与常见问题解答,指出在中大型团队中将分列规则纳入协作与审计体系的重要性,最终形成“读取-清洗-分列-校验-落盘”的稳健闭环,满足分析与ETL的长期可复用需求。

Rhett Bai

Rhett Bai- 2026-01-14

python中如何判断字符串

本文系统阐述了在Python中判断字符串的三层路径:首先用isinstance确保文本类型,其次以isX系列和前后缀/子串完成高效校验,最后用正则处理复杂规则。文章强调Unicode规范化、casefold大小写无关比较与isdecimal/isdigit/isnumeric的语义差异,并提出以清洗流水线、长度白名单与参数化转义保障安全。在工程落地上,建议编译复用正则、以timeit量化性能,并在CI与项目协作流程中固化规则;必要时可结合PingCode与代码仓库联动以提升可追溯性与执行力。

Joshua Lee

Joshua Lee- 2026-01-13

python如何进行数据比对

本文系统阐述了用Python进行数据比对的完整路径:先明确比对粒度与匹配类型,再用哈希、集合对齐、模糊匹配与pandas/Polars管线实现差异检测,按“对齐-差异-验证-报告”四步法工程化落地,并结合Dask/Spark扩展至大规模场景;同时引入断言与度量构建数据质量治理,输出可审计报告与告警,最终在协作流程中实现闭环管理与持续优化。

Joshua Lee

Joshua Lee- 2026-01-13

python如何处理空数据

本文系统回答了“Python如何处理空数据”:先明确None、空容器、空字符串与NaN/NA的语义边界,再用“is None”、len与pandas.isna等规则进行准确判定;结合默认值、Sentinel模式与防御式编程减少误判;在数据分析中以向量化的isna、mask与fillna构建稳定清洗管道;通过类型注解、验证框架与日志监控把空值治理工程化,并在团队流程中固化规范与可视化反馈;最后展望可空类型与统一NA语义的趋势,强调将治理融入协作平台与项目交付以形成持续的组织能力。

William Gu

William Gu- 2026-01-06

python如何获取网页表格

本文系统阐述用Python获取网页表格的可行路径:先判断页面为静态或动态,静态用pandas.read_html或BeautifulSoup/lxml快速解析,动态优先复用JSON API,其次再用Selenium/Playwright渲染兜底;围绕定位、清洗、分页合并与去重构建稳定提取器,并通过持久化与数据校验形成闭环;在工程化层面强调速率控制、缓存、重试与告警,同时遵循robots与合规边界;文中提供方法对比表与选型建议,并展望前端渲染与反爬升级的大势下,API合作与工程化能力的重要性提升。

Rhett Bai

Rhett Bai- 2026-01-06

汇报数据错误如何处理

本文系统阐述了汇报数据错误的应对策略,从“立即止损与公告、定位根因与修复、复盘与预防”三步建立闭环。文中强调以数据治理与可观测为核心,通过统一口径、数据血缘、质量规则与自动化校验,缩短异常检测与修复时间,并将变更管理与协作流程标准化,减少错误外溢与决策风险。文章同时建议在研发和跨部门场景中结合协作系统进行透明化管理,辅以演练与度量优化,形成可持续的治理体系与工程化质量保障。

Elara

Elara- 2025-12-30

测试结果如何汇报

本文系统回答了测试结果如何汇报的问题:围绕决策构建统一结构的报告,分层面向不同受众,按日、迭代、发布、回归四类场景设定节奏;用数据驱动的指标与可视化展示覆盖率、缺陷密度与风险矩阵,给出选项化的发布与缓解建议;通过工具打通与自动化仪表板提升时效性,并对齐行业标准增强可信度;在需要研发全流程关联的场景可使用PingCode完善链路与度量,在通用协作场景用Worktile保持任务推进;未来趋势将以AI辅助总结与端到端可观测融合,令测试报告更可决策、可追踪与可改进。

William Gu

William Gu- 2025-12-29

检测工作如何汇报

检测工作汇报应以结论先行、数据支撑、行动闭环为主线,围绕覆盖率、缺陷与效率指标清晰呈现质量状态与风险,并依据受众差异化设计视图与颗粒度。通过统一的数据管道与度量口径提高可信度,将报告与项目协作系统连接,确保从指标异常到责任人和截止时间的可操作链路。在软件、合规审计与现场检验等典型场景中采用标准化模板与证据索引,兼顾决策效率与审计可追溯。持续优化报告结构与指标集,关注Shift-left与AI辅助等趋势,使检测汇报成为质量治理和资源配置的有力抓手。

Joshua Lee

Joshua Lee- 2025-12-29

如何管控项目质量计划

本文阐明管控项目质量计划的核心路径:通过明确质量目标与验收标准、建立QA与QC闭环、构建可度量指标与看板并实施审计,将质量变为可治理的“活文档”。文章强调用PDCA驱动持续改进、以风险矩阵与变更控制稳住交付可靠性,并通过模板化检查表、自动化与证据化提升执行一致性。在多方协作与供应商场景中,配置RACI与SLA,结合平台化工具实现端到端追踪。未来,智能化度量、平台化治理与生成式辅助审查将加速质量管理的数字化升级。

Elara

Elara- 2025-12-26

信息工作如何提升质量

要提升信息工作质量,需要将治理、标准与度量构成闭环,通过明确角色与政策、统一风格指南与模板、强化元数据与分类体系、建立审核闸门与版本管理,并以指标与可观察性持续监测改进。结合自动化与AI进行断链检测、术语校验与摘要复核,同时将合规与安全内嵌到流程。在协作与研发场景中借助平台化工作流,如在研发文档与需求闭环中应用PingCode,在跨部门协作中使用Worktile,使高质量的信息生产成为可执行、可复制的组织能力。

William Gu

William Gu- 2025-12-22

如何更正工作表

本文给出可复现的工作表更正方法:先界定错误类型与影响,建立风险评估与优先级,然后分步修复数据、公式与结构并记录版本与审计日志;通过数据验证、条件格式与保护机制防止脏数据与误操作,再以脚本或查询实现自动化清洗与回归测试。对于跨部门场景,借助协作平台以工单化管理更正任务,并将修复与验收纳入项目节奏,必要时在研发环境中引入支持全流程管理的工具,使更正形成“发现—修复—验证—发布”的闭环,提升数据质量与合规性。

Elara

Elara- 2025-12-22