如何要人工智能的腿照

获取AI腿部照片的关键在于选择合规的生成工具、使用结构化且安全的提示词、落实版权与来源标识并进行人审。通过明确非色情与商业合规用途、结合负面提示排除不当元素,能稳定生成可投放的时尚与教育素材。国内外平台各具优势:闭源云服务更注重内容安全与许可,开源生态更强调姿态与细节可控。最终以迭代评估、透明发布与SEO优化形成可复用工作流,确保质量与合规并重。

Rhett Bai

Rhett Bai- 2026-01-17

人工智能如何建立价值观

文章提出以多层防线与闭环治理让AI建立价值观:通过价值发现与规则固化,将社会、法律与组织价值转译为数据与目标;以SFT、RLHF/RLAIF和宪法式AI建立内生偏好,叠加护栏与权限治理控制外部行为;依托NIST与Gartner框架搭建端到端治理与评测体系;最终以平台化编排、红队常态化和线上观测持续迭代,实现可审计、可回滚的价值对齐工程。

Rhett Bai

Rhett Bai- 2026-01-17

人类与人工智能如何共处

人类与人工智能的共处需要以人为本的原则与清晰边界,建立风险分级与场景分层的治理体系,并以透明、可解释、隐私保护与安全为技术基线;在工作与产业实践中推行人机协作分工与人类最终审签,配套教育与终身学习、社会安全网升级,促使劳动力平稳转型;企业应以可证据化合规与跨职能治理提升可信度,结合国内与海外生态的互补优势,按数据敏感度与集成成本选择工具;未来三到五年,AI治理审计普及、个人AI助理常态化、行业垂直与多模态加速落地,创新与安全将实现动态平衡。

Rhett Bai

Rhett Bai- 2026-01-17

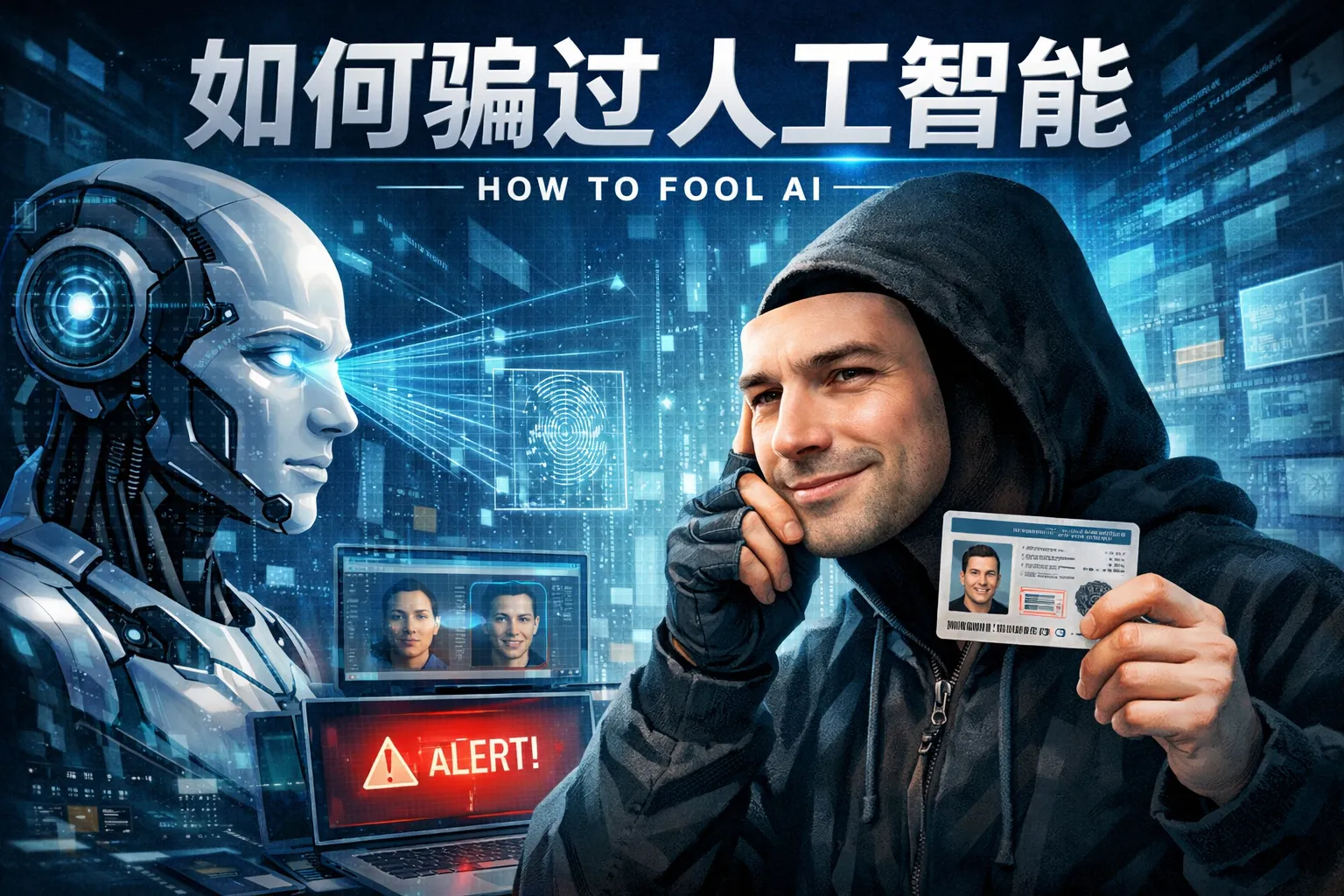

如何骗过人工智能

本文指出“骗过人工智能”既不合法也不具备可持续性,现代AI系统部署了多层防线、审计与合规框架,偶发绕过不可复用且风险高。更优路径是提升AI素养,通过正当的提示工程、受控红队演练与企业级AI治理(如NIST AI RMF、AI TRiSM)提升质量与安全。文中分析了提示注入、越狱与对抗样本等常见误区的技术与风险,并提出用户与企业的合规实践,包括数据治理、模型监控、内容安全与人审兜底。结论:没有稳定的“骗AI”方法;应以透明、审计与负责任AI为基线,与人工智能建立可靠协作。

William Gu

William Gu- 2026-01-17

人工智能如何控制人性

本文指出人工智能无法也不应“控制”人性,它通过推荐、默认与激励等选择架构影响注意力、情绪与决策,若缺乏透明与选择权便产生“被控制感”。文章系统解析注意力捕获、情绪调谐、选择架构与社交放大四大机制,比较国内外产品中常见“软控制”模式,并提出以透明、选择权、审计与合规为核心的治理框架,给出衡量“健康参与”的多目标指标与工程方法。结论与趋势认为多模态与个体化代理将增强影响力,需以AI TRiSM、外部评估与脆弱群体保护构建信任,使AI成为增强自主而非操纵的工具。

Joshua Lee

Joshua Lee- 2026-01-17

如何反抗人工智能

本文提出合规“反抗人工智能”的系统方法,强调维护隐私、选择权与人类主导权。核心策略涵盖个人层面的数据最小化与选择退出、组织层面的AI治理与可解释性、人机协作与问责、创作者的真实性标记与版权主张、技术选型的本地化与开源可控,以及公共政策参与与权利行使。通过指标化衡量与持续迭代,将抵抗转化为可验证的成果;同时以透明、合规与数据化的方式构建长期韧性,既利用AI的效率,又守住人的尊严与选择权。未来,隐私计算、可解释AI与内容溯源机制将成为基础设施,AI治理内建化提升规则与公信力。

Elara

Elara- 2026-01-17