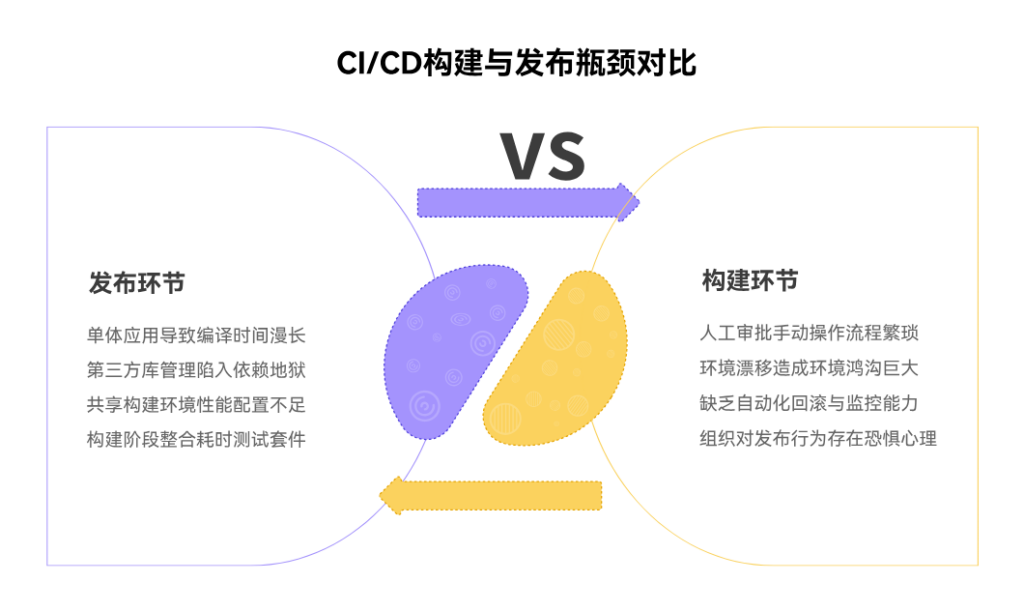

CI/CD(持续集成/持续交付)流程之所以经常在“构建”与“发布”这两个关键环节遭遇瓶颈,其根本原因在于,这恰恰是技术债、环境复杂性、流程断点与组织文化惯性相互碰撞、矛盾最为集中的两大“关隘”。在“构建”环节,核心症结在于:日益庞大臃肿的单体应用所带来的、无法忍受的漫长编译时间、复杂且脆弱的、被称为“依赖地狱”的第三方库管理难题、性能严重不足且配置不一的共享构建环境、以及被错误地、同步地整合进构建阶段的、大量耗时过长的重量级自动化测试套件。

而在“发布”环节,则主要受阻于:以繁琐的人工审批和高风险的手动操作为主导的、前现代的发布流程与变更管理文化、生产环境与测试环境之间因“环境漂移”而产生的、难以弥合的巨大鸿沟、以及因普遍缺乏可靠的、一键式的自动化回滚与精准的实时监控能力,而产生的对“发布”这一行为本身的、深刻的组织性“恐惧”心理。这些技术、流程与文化上的“堵点”相互交织,共同导致了本应像水一样顺畅流动的价值交付流水线,在这两个决定性的节点上,频繁地“卡顿”、“拥堵”甚至“中断”。

一、构建之“慢”:编译与依赖的“时间黑洞”

在CI/CD流水线的起点,“构建”环节的缓慢,是扼杀团队敏捷性的第一个、也是最常见的“时间黑洞”。对于许多仍在使用庞大单体式架构的团队而言,仅仅是“编译”这个动作,就可能耗费数十分钟甚至数小时的时间。每一次代码提交,都需要触发对整个、包含了数百万行代码的“巨石”进行全量编译,开发者提交代码后,不得不进入漫长的等待,才能获得第一次反馈。这种迟钝的反馈循环,彻底违背了持续集成“快速失败、快速修复”的核心原则,极大地打击了开发人员提交代码的频率和意愿。

与漫长编译相伴相生的,是更为棘手和脆弱的“依赖地狱”问题。现代软件开发,高度依赖于大量的第三方开源库和内部共享模块。当这些依赖关系没有被有效管理时,构建过程就会变得极其不可靠。构建服务器可能因为需要从缓慢的外部源,临时下载大量的依赖包,而耗费大量时间;不同模块之间,可能引入了同一个库的、相互冲突的不同版本,导致构建在解决依赖冲突时失败;甚至,某个上游的、不稳定的内部共享库的一次错误更新,就可能引发下游所有依赖它的项目的构建“集体雪崩”。在这种脆弱的依赖关系网中,每一次构建,都像是一场“掷骰子”游戏,充满了不确定性。团队不得不花费大量的精力,去处理那些与业务逻辑本身无关的、纯粹由依赖管理不善所引发的环境问题,这无疑是巨大的效率浪费。

二、环境之“沙”:构建节点的性能瓶颈与不一致性

构建过程的效率和稳定性,在很大程度上,取决于其运行的“土壤”——即构建服务器(或称构建节点/Agent)的质量。然而,在许多组织的实践中,这片“土壤”却常常是贫瘠的、被忽视的,充满了性能瓶颈与不一致性的“沙粒”。一个常见的反模式,是整个公司或多个团队,共同使用少数几台配置陈旧、性能低下的物理服务器,作为共享的构建资源。当多个项目同时触发构建时,这些服务器的CPU、内存和磁盘I/O会迅速达到瓶颈,导致所有构建任务都需要排队等待,或者在一种极其缓慢的状态下运行。

比性能瓶颈更致命的,是构建环境的“不一致性”。这些长期运行的、由人工维护的构建服务器,其环境会随着时间的推移,而变得越来越“个性化”。不同的服务器上,可能安装了不同小版本的操作系统补丁、Java/Python等运行时环境、或是各种编译工具。这就导致了一种极其诡异和令人沮丧的现象:同一个代码提交,在A构建节点上能够成功,但在B构建节点上,却因为环境的细微差异而莫名其妙地失败。这种“薛定谔的构建”,使得开发人员需要花费大量时间,去排查那些并非由自己代码引起的环境问题。这也是为什么,以Docker为代表的容器化技术,会成为现代CI/CD实践的基石。通过将构建环境,打包成一个轻量、可移植、用完即毁的容器镜像,可以从根本上,确保每一次构建,都在一个100%纯净、一致、可预测的“无菌”环境中进行,彻底告别环境不一致所带来的混乱。

三、测试之“重”:被误置于构建环节的“刹车片”

自动化测试,是保障CI/CD流程质量的核心。然而,对自动化测试不恰当的、错误的组织和编排,恰恰是导致构建环节变得异常缓慢的另一个重要原因。一个普遍的误区,是将所有类型的自动化测试,不加区分地,全部“塞”进主干流水线的、同步的、阻塞式的构建验证阶段。尤其是那些运行时间极长、极其消耗资源的“重量级”测试,例如,需要启动完整应用和数据库的、端到端的UI自动化测试。

这种做法,违背了著名的“测试金字塔”(Test Pyramid)原则。该原则指出,一个健康的测试策略,应该由大量的、运行速度极快的“单元测试”作为金字塔的底层基础;中间是数量适中、运行稍慢的“服务/集成测试”;而位于塔尖的,则应该是数量很少的、运行最慢的“UI/端到端测试”。当团队将大量“塔尖”的测试,与“塔底”的测试,混杂在一起,并要求它们必须在每一次代码提交后的CI构建中全部通过时,这些重量级的测试,就成了流水线中一个个巨大的“刹车片”。它们将快速反馈的周期,从理想的“几分钟”,拖延到了“几十分钟”甚至“数小时”。正确的做法,是将不同类型的测试进行分层、解耦和并行化,将最核心、最快速的单元测试和静态代码扫描,作为CI构建的“守门神”;而将那些更耗时的集成测试和端到端测试,则可以放在独立的、异步的、或者只在夜间运行的测试流水线中进行。

四、发布之“惧”:手动操作与“审批之墙”的阻碍

当代码成功地通过了构建和测试,进入到“发布”这个“临门一脚”的环节时,瓶颈的形态,便开始从纯粹的“技术”问题,更多地,转向了“流程”和“文化”问题。在许多企业,尤其是在传统行业,围绕着“生产环境变更”这一事件,建立起了一套极其繁琐、以手动操作和层层审批为核心的、充满了“仪式感”的发布流程,其背后,是一种对“生产环境”深刻的、根深蒂固的“恐惧”文化。

这种“发布恐惧症”,直接物化为了一堵堵高耸的“审批之墙”。任何一次发布,都可能需要提前数周,填写一份复杂的变更申请单(Change Request),然后经过项目经理、部门总监、测试经理、运维总监,乃至一个由各方代表组成的“变更咨询委员会”(CAB)的层层审阅和签字。这个过程,充满了漫长的等待和低效的沟通。与审批相伴的,是极度依赖“人肉”的手动操作。发布过程,通常由运维工程师,严格地、小心翼翼地,按照一份长长的、可能早已过时的“发布操作手册”(Release Runbook),一步步地,在生产服务器上,手动地执行命令、拷贝文件、修改配置。整个过程,不仅效率低下,而且因为人的不可靠性,而充满了巨大的操作风险。在这种文化和流程下,发布,不再是一个可以被轻松、频繁进行的日常活动,而变成了一场需要“兴师动众”、在“深夜”或“周末”进行的、高风险的“外科手术”。

五、环境之“诡”:生产环境的“漂移”与不可预测性

支撑着“发布恐惧”文化的、最坚实的技术原因,就是生产环境的“不可预测性”。在传统的、由人工维护的IT环境中,生产环境、测试环境、开发环境之间,几乎永远不可能做到100%的一致。随着时间的推移,它们之间的差异,会因为一次次的紧急补丁、手动的配置修改、不同步的软件版本升级,而变得越来越大,这种现象,被称为“环境漂移”(Environment Drift)。

“环境漂移”,使得每一次发布,都像是一场“赌博”。一个在测试环境中表现完美的应用程序,在被部署到生产环境后,却可能因为操作系统的一个微小版本差异、一个配置文件中被遗忘的参数、或是一个被依赖服务的不同网络配置,而立刻崩溃。这种“在测试环境工作得好好的,一到生产就出问题”的诡异现象,是开发与运维之间,无数次争吵和“甩锅”的根源。它使得发布的结果,变得高度不可预测,从而进一步强化了运维团队“稳定压倒一切”的保守心态,让他们对任何来自开发的变更,都抱持着深深的怀疑和抵触。要从根本上铲除这颗“毒瘤”,唯一的解药,就是全面地拥抱“基础设施即代码”(Infrastructure as Code, IaC)的理念,将所有的环境配置、网络拓扑、依赖关系,都用代码(如Terraform, Ansible)的形式,进行严格的、版本化的管理,确保可以一键式地、可重复地,创建出与生产环境100%一致的测试环境。

六、回滚之“殇”:缺乏“降落伞”的“高空作业”

人类之所以敢于从事一些高风险的活动,例如高空跳伞,其前提,是因为我们拥有一个可靠的、能在出现意外时,快速保障我们安全的“降落伞”——备用伞。在软件发布这个同样是“高空作业”的活动中,这个“降落伞”,就是“快速、可靠的自动化回滚能力”。然而,在许多组织的CI/CD流程中,这个最重要的安全保障,却是缺失的。

当一次发布在线上引发了严重故障时,团队才惊恐地发现,他们并没有一个经过演练的、一键式的“回滚”预案。回滚过程,可能需要进行一次比发布本身更复杂、更紧张的手动操作,甚至需要开发人员,紧急地修复Bug,然后重新进行一次漫长的构建和发布流程,来进行“向前修复”(Fix Forward)。这种回滚的“无能”或“低效”,使得每一次发布,都成了一次“开弓没有回头箭”的、极其危险的“单程旅行”。当犯错的成本如此之高时,为了避免犯错,团队必然会不惜一切代价,去增加发布的流程、加长测试的周期、减少发布的频率。这正是为什么,现代的发布策略,如“蓝绿部署”、“金丝雀发布”等,其核心思想,并非是让发布本身100%不出错,而是通过部署冗余环境和流量切换的方式,确保即便发布出了问题,也能够在一秒钟之内,将用户流量,无感知地、安全地,切换回那个稳定可靠的旧版本,从而将“回滚”这个动作,从一场惊心动魄的“事故处理”,变成了一次云淡风轻的“常规操作”。

七、疏通“堵点”:构建快速、可靠、可重复的交付流水线

要将CI/CD流程中,构建与发布这两个最顽固的“堵点”彻底疏通,组织必须采取一套“技术实践”与“文化理念”相结合的系统性解决方案。其核心目标,是围绕着“降低构建时长、提升环境一致性、简化发布流程、增强回滚信心”这几个关键点,去重塑整个价值交付流水线。

在“构建”端,优化的核心在于“拆分、并行、缓存”。对于庞大的单体应用,需要有计划地,向更小、更独立的“微服务”架构进行演进,从根本上缩小单次构建的范围。要建立高效的、中心化的“依赖缓存”机制,避免重复下载。要利用容器技术,实现干净、一致、可一次性的构建环境。要将测试进行分层,将耗时的重量级测试,从主干流水线中剥离,并进行最大程度的并行化处理。在“发布”端,变革的核心在于“自动化、代码化、渐进化”。必须用“基础设施即代码”和“GitOps”的模式,来彻底消灭“环境漂移”。必须废除繁琐的、基于信任链的手动审批,转而依靠在流水线中,内置的、自动化的质量门禁和安全扫描,来进行“代码化的治理”。必须采用蓝绿部署、金丝雀发布等“渐进式交付”(Progressive Delivery)策略,来将发布的风险,控制在最小的范围内。要快速定位这些堵点,一个能够提供端到端可追溯性的平台至关重要。例如,通过像智能化研发管理系统PingCode这样的平台,可以将每一次构建失败或发布告警,都自动关联回具体的代码提交、需求变更甚至缺陷报告,极大地缩短了故障排查和修复的时间。通过这一系列深刻的、系统性的变革,组织才能最终,将一条充满了“堵点”和“险滩”的“羊肠小道”,改造为一条能够持续、快速、可靠地,将价值,输送给最终用户的“信息高速公路”。

常见问答

问:我们的单体应用构建一次确实非常慢,但团队认为这是因为业务逻辑本身就极其复杂,是一种“必要之恶”,难以优化。我们该如何客观地判断,构建缓慢,是真的“必要”,还是其实存在着巨大的、被忽视的优化空间?

答:这是一个非常普遍的观点,但99%的情况下,它都是一种需要被挑战的“思维定式”。要客观判断,需要引入“数据度量”和“瓶颈分析”的工程化方法。1. 将构建过程“可视化”。首先,需要利用CI/CD工具的插件或日志分析功能,将整个构建过程,分解为一个个清晰的、可度量的阶段(如:代码检出、依赖下载、代码编译、单元测试、代码扫描、打包等),并精确地测量出每个阶段的耗时。这样,构建慢的“罪魁祸首”,就会从一个模糊的“业务复杂”的“印象”,变成一个具体的、指向某个特定阶段的“数字”。2. 针对最长耗时环节,进行深度剖析。如果发现是“依赖下载”耗时最长,那就应该去审视,是否建立了有效的内部依赖缓存(如Nexus, Artifactory)。如果发现是“单元测试”耗时最长,那就应该去分析,测试用例是否可以被更有效地分组和并行化执行?是否存在一些效率极低的“测试大户”?3. 引入“构建分析”工具。对于更复杂的编译性能问题(如Java的Maven/Gradle,前端的Webpack),可以引入专门的构建分析工具(如Gradle Build Scan, Webpack Bundle Analyzer),它们能够像“X光”一样,透视整个编译过程,清晰地揭示出是哪个插件、哪个模块、哪个任务,消耗了最多的时间。4. 设定一个“挑战性”的优化目标。可以设定一个例如“将构建时间缩短50%”的目标,并将其作为一个正式的技术项目,成立一个虚拟的“构建优化小组”,进行集中的、为期一到两周的攻关。你通常会惊奇地发现,通过一系列例如“升级编译插件版本”、“开启并行编译选项”、“优化测试用-例依赖”等看似微小但精准的改动,构建效率能够得到数倍的、戏剧性的提升。

问:我们非常想推行自动化的、更频繁的发布,但运维和测试团队,以“生产环境风险太大”、“测试不充分”为由,强烈反对,并坚持现有的、严格的多级人工审批流程。该如何打破这个僵局?

答:这个僵局的根源,在于双方对“风险控制”的手段和理念,存在着巨大的代沟。破局的关键,在于不能直接去挑战他们“控制风险”的目标(这个目标是完全正确的),而是要向他们证明,我们有“更先进、更可靠、而非更草率”的、新型的风险控制手段。1. 从“建立信任”开始,而非“争夺权力”。可以邀请运维和测试的同事,加入到一个小型的、非核心应用的“自动化发布试点项目”中。在这个项目中,不要去讨论是否要“取消”审批,而是与他们一起,共同地、将他们现在“手动”在做的大量的、重复的“发布前检查”和“发布后验证”工作, 하나하나地,用自动化的脚本和质量门禁,在流水线中进行“复现”和“固化”。2- 将“人工审批”转变为“代码化治理”。向他们展示,通过在流水线中,嵌入自动化的安全扫描、性能测试、合规检查等步骤,机器可以比人,更可靠、更严格、更不知疲倦地,去执行那些早已定义好的“质量标准”。审批的逻辑,从“人”的主观判断,转移到了“代码”的客观校验上。3- 引入“渐进式发布”作为安全阀。向他们介绍并演示,通过蓝绿部署或金丝雀发布,我们可以在不影响绝大多数用户的情况下,先将新版本发布给一小部分内部用户或极少数外部用户,进行“小流量”的、真实环境的验证。一旦出现问题,可以在秒级内,将流量切回老版本,其风险远低于传统的、全员“一刀切”的发布模式。通过这样一个“以退为进”、“用更先进的控制代替旧的控制”的沟通和实践路径,就能够逐步地,将运维和测试同事,从变革的“阻力”,转变为新模式下“质量和稳定性的新守护者”。

问:蓝绿部署、金丝雀发布这些高级的发布策略,听起来就对我们的基础设施和应用架构,提出了非常高的要求。对于我们这样,技术基础还比较薄弱、应用还是个大单体的传统企业,这些策略是否遥不可及?

答:这些高级策略,确实需要一定的技术基础作为支撑,对于一个庞大的、紧耦合的单体应用,直接实现完美的蓝绿部署,可能是非常困难的。但是,这绝不意味着它们是“遥不可及”的,关键在于**“从理念入手,简化实践,小步快跑”**。1. 核心是“解耦”和“无状态化”。即便不能立刻将整个单体应用进行蓝绿部署,我们也可以先从改造应用本身开始。推动开发团队,在架构上,将应用的“状态”(如用户会话、临时文件)与应用本身进行分离,存储到外部的分布式缓存或存储系统中。同时,将那些耦合最紧密的、变更最频繁的功能模块,逐步地、优先地,进行“微服务化”的拆分。这是未来能够实现高级发布策略的、最重要的“铺路”工作。2. 从“最简单”的蓝绿部署开始。最朴素的蓝绿部署,在基础设施层面,无非是准备“两套”一模一样的服务器集群。在发布时,将新版本部署到“闲置”的那一套集群上,进行充分的测试,然后通过修改负载均衡(Nginx, F5等)的配置,将用户流量,一次性地,从“蓝色”集群,切换到“绿色”集群。这个过程,虽然依然是整体切换,但已经具备了“快速回滚”(只需将流量切回去即可)的核心优势,其风险,远低于在“唯一”的生产环境上,进行“原地升级”。3. 用“功能开关”(Feature Flag)模拟“金丝雀”。对于单体应用,可以通过在代码中,引入“功能开关”的机制,来实现业务层面的“金丝雀发布”。即,将新功能相关的代码,包裹在一个开关逻辑里,发布上线时,这个开关默认是“关闭”的。然后,可以通过配置中心,为特定的、小范围的用户(如内部员工、VIP用户),打开这个开关,让他们来“尝鲜”和验证新功能。这种方式,虽然没有实现流量的物理隔离,但同样达到了“风险隔离”和“渐进式灰度”的核心目的。通过这些务实的、简化的、渐进式的实践,传统企业完全可以,在自己现有的技术基础上,逐步地,享受到现代发布策略所带来的、巨大的稳定性红利。

文章包含AI辅助创作,作者:mayue,如若转载,请注明出处:https://docs.pingcode.com/baike/5217017