距离Intel Arc(锐炫)显卡正式上市也过去好几个月了——这是Intel近代交出PC独立显卡的名列前茅份答卷。电子工程专辑过去这段时间也写了不少有关锐炫(Arc)显卡及GPU架构的文章,微信视频号还做过Arc显卡的评测。

在此期间,Intel当然也没有闲着,针对已上市的独显发布了8个大版本的驱动更新。Intel院士(fellow)Tom Petersen此前就说过,驱动是做独显的真正难点。而驱动效率水平是GPU成熟度的最直接写照。

作为PC独显的新入市者,要在既有的双寡头市场上取得地位,必然是要面临阵痛期的——毕竟英伟达和AMD已经在这个市场上耕耘了几十年的时间。尤其前者在PC图形加速领域的生态地位难以撼动。不难理解在Arc发布早期,有关产品存在bug和效率问题的争议就不断,这是成熟市场上新晋市场参与者都要面对的。

2月初,Intel发布了Q1’23 Arc Update驱动更新,还专门开了个媒体会,提及本次驱动更新对于Arc显卡的重大意义,尤其在DirectX 9老游戏上,相比早期版本的驱动能实现平均43%的性能提升。43%是个什么概念呢?更新一下驱动,约等于买了块新显卡的概念…

当然一般官方数据在呈现上多少会有些偏向性。我们最近拿到了Intel Arc A750 Limited Edition 8GB显卡,恰有机会来简单实测一下,新驱动有没有为老游戏带来什么体验上的飞跃;顺便从中看一看Intel在生态构建上的努力程度。

Intel的Arc独显产品线,根据定位在数字上也分成 3、5、7不同档。A750在A系列中定位偏高端。这块显卡上的GPU芯片部分用的是和A770一样的ACM-G10 die,通过binning限定核心和计算单元的数量。Arc A750的配置情况如下,顺便和我们此前体验过的Arc A380做个比较:

有关光追、AI超分(XeSS)以及媒体引擎之类的特性支持,以及Xe-HPG架构设计,这里就不多着墨了,此前的分析文章有相当详细的探讨。

我们手上这块Arc A750乃是Intel公版。其实ACM-G10这片die仅晶体管用料来看,已经达到了隔壁RTX 3070的程度。但在2月初降价之后,目前Arc A750在京东上的售价是1999元,比GeForce RTX 3060最便宜的卡还便宜了600块钱。

一方面这是Intel称其性价比超过3060的依据,另一方面其实也一定程度看出了Intel的无奈。无论如何,对显卡市场和消费用户而言终归是好事。

板级和系统设计不是我们要关注的重点,不过Arc A750 LE这张卡的长相真的堪称PC显卡中的尤物——极简风格,和相对柔和的设计语言,与市面上大部分显卡的“张牙舞爪”还是形成了鲜明的对比的。这就让Arc A750 LE的整体质感相当出众。

照例先谈谈本次体验测试的平台和方法。沿用此前我们体验13代酷睿处理器的平台,大致配置信息如下:

对比的两版驱动程序版本:

对于这个测试平台,有经验的同学应该会质疑其中可能存在的两个瓶颈:一是散热方案是否会成为CPU发挥的瓶颈,二是供电方面的,550W电源是否足够CPU和GPU全速运转。

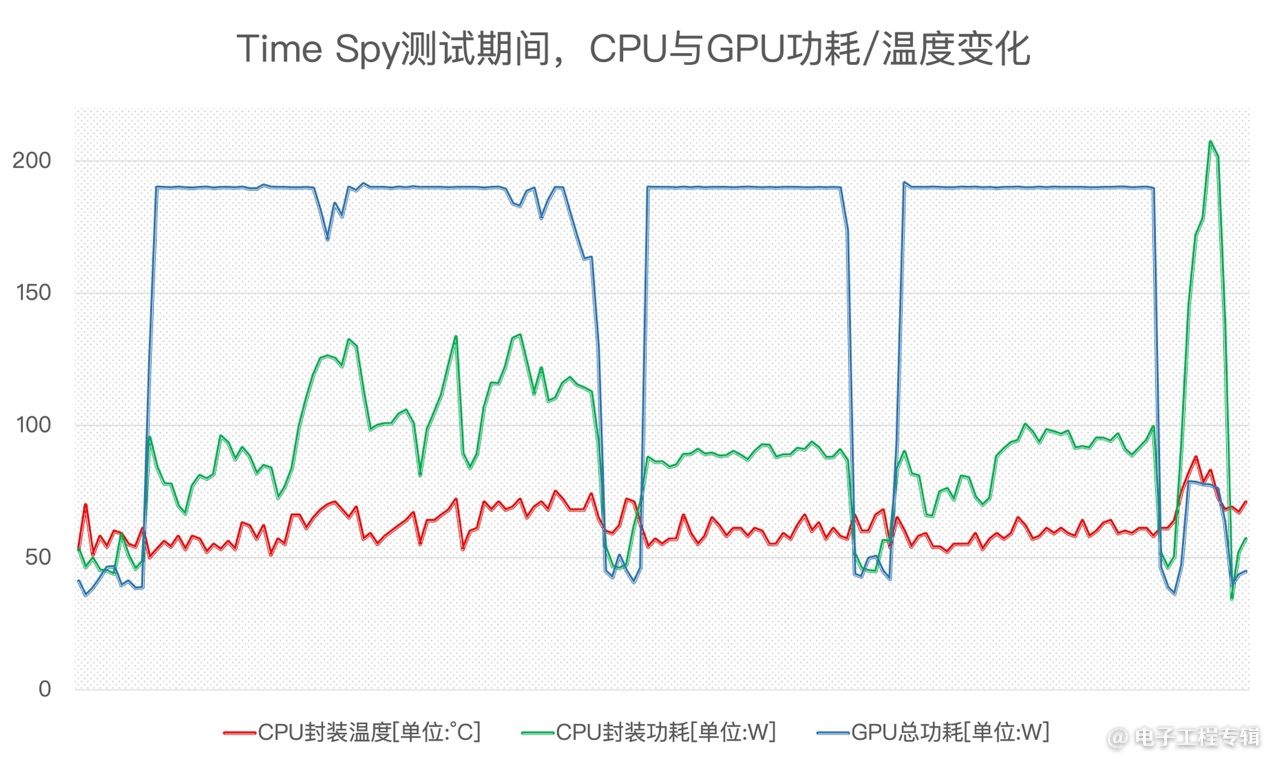

对于后一个问题,我们在游戏测试之前也进行了Furmark+AIDA64双烤测试,这块Arc A750显卡全速跑起来较高大约是190W总功耗,CPU封装功耗稳定在250W,用550W的电源没有什么问题。

至于风冷散热是否成为瓶颈……此前13代酷睿CPU评测文章里详细谈到过这一点——单就酷睿i9-13900K满负载,这款塔式双风扇的确构成了散热瓶颈,令CPU难以全速运转。但这次我们测试的基本都是游戏。在我们监测的所有游戏里,没有对CPU存在长时间满载需求的应用;且绝大部分游戏的CPU负载都不算特别高。

以上是系统在跑3DMark Time Spy图形渲染测试过程中,CPU、GPU的功耗与温度变化曲线。Time Spy的前三个子项测试中,Arc A750基本是满负荷在跑的。酷睿i9-13900K的功耗在100W上下浮动,封装温度也远不到80℃;

最后一个子项测试,考察的是物理计算和模拟,是特别针对CPU的压力测试(尤其SSSE3)——这应该是比较能够反映游戏场景里,CPU重负载的情况的。上图的最后一段曲线可见,CPU功耗的确出现了飙升,但仍离温度墙有距离。可见该测试平台下,起码在游戏测试里,CPU的散热不会构成性能瓶颈。

因为时间关系,这篇文章主要就测游戏。实际上当代个人电脑GPU的使命远不仅限于游戏——图形渲染相关的还有专业视觉应用;另外GPU现在也很重于通用计算加速,以及多媒体编解码特性。这些部分的体验,本文仅略有涉及,具体的测试可以关注电子工程专辑的微信视频号或者B站企业号,我们会在后续更新的体验视频中给出A750这张卡的更多信息。

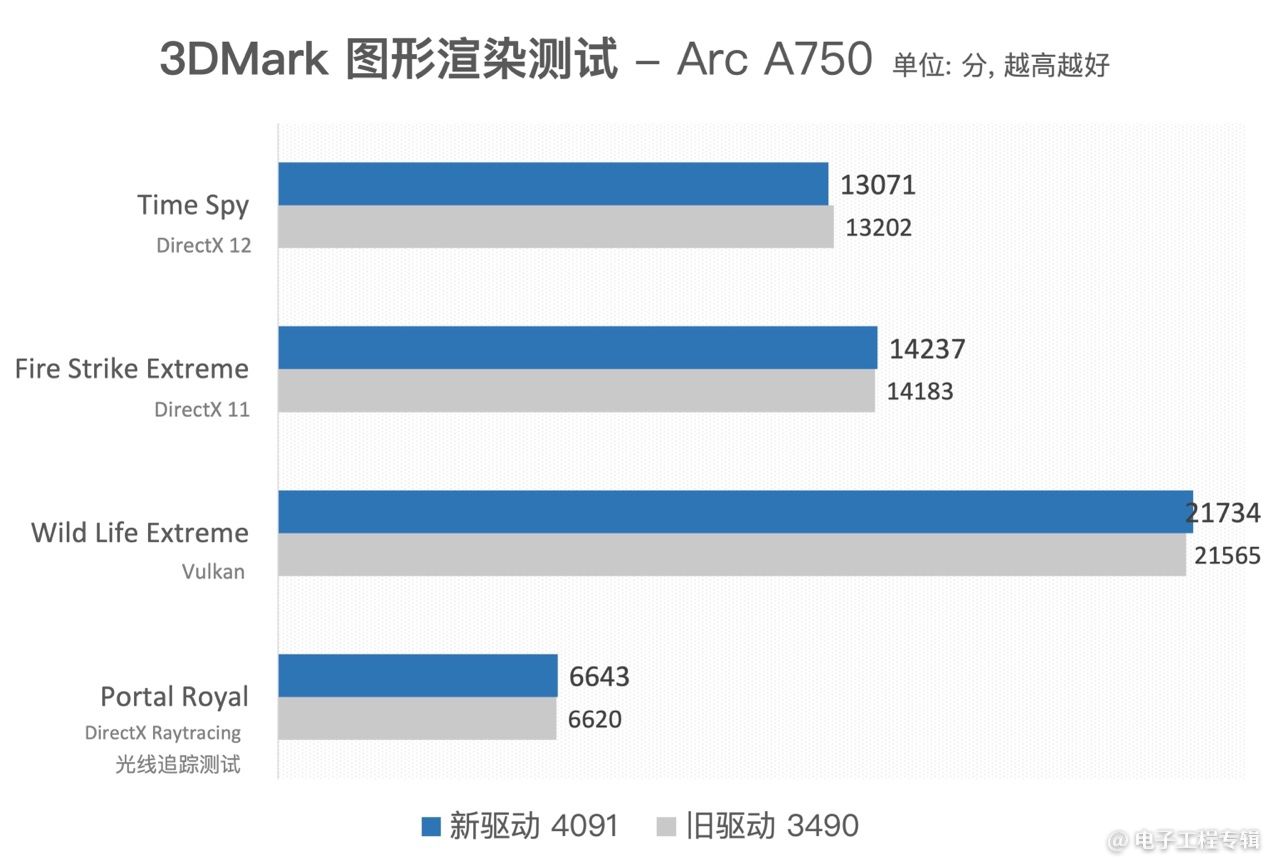

既然是测游戏,3DMark图形渲染测试是必不可少的。我们选了分别代表DirectX 12、DirectX 11和Vulkan这几个主要图形API的测试项来做比较,结果如下:

注意本文关注的重点是两个不同版本的驱动,在性能和体验方面的差异。似乎就3DMark针对DirectX 11/12和Vulkan API的测试来看,两版驱动的理论跑分是没什么变化的。

从跑分基数来看,Arc A750这几个项目的得分还是有些高得惊人——比如Time Spy项目,RTX 3060在这个项目的成绩还不到10000。但关注PC显卡的同学应该也知道,A750/A770在实际游戏中仍有进步空间。

我们过去一直不大理解为何3DMark的测试被称为“理论跑分”。因为3DMark的所有测试项也是构建于驱动、API和中间件之上的,它仍是个高层级的测试——这一点和游戏是一样的。

在前不久的媒体沟通会上,Tom Petersen曾经大致提到过这个问题。他说:“基准测试得到的成绩,表现的是硬件设计的马力水平(horse-power)。硬件涉及到计算吞吐、存储带宽之类的复杂问题。”

“在基准测试中,我们能够跑出最完美的成绩(we deliver everything runs perfectly)。”Tom说,“但我们发现,这和实际的游戏还是不一样。我感觉我们很难针对实际游戏,(像基准测试那样)做大范围的优化工作。”“很多游戏并没有对Arc做优化。”

“如果开发者不去针对我们的架构做游戏方面的改动,我们应该很难获得3DMark基准测试表现出来的那种性能水平。不过,将来的情况会越来越好。”在我们看来,3DMark测试成绩更像是Intel名列前茅方针对游戏市场交出的答卷;但游戏开发者作为第三方,如何利用Arc显卡及其实际生态表现又是另一个问题。这可能仍然涉及到其他市场参与者先发优势的问题。

举个简单的例子,这次测试部分老游戏的时候,我们发现很多游戏和当时的英伟达或AMD都有直接的合作,或者针对当时的显卡有特别优化。比如说《无主之地2(Borderlands 2)》《蝙蝠侠:阿卡姆之城》这两个游戏,在画质设定中,都有专门的Nvidia PhysX物理加速特效——这样的项目在采用Arc显卡时自然是无法开启的。

可见对于PC显卡而言,生态问题和市场直接挂钩。

其实PC显卡市场一路走来几十年,双寡头局面也已经很多年了。这样的格局都表明,起码在图形渲染领域,这一市场已经高度成熟。一般很少有人会在高度成熟的市场中,作为后来者再去竞争——这往往意味着短期内数倍于寡头的投入,才有一定概率获得市场份额。

在微软的DirectX API都几经迭代的显卡洪流中,Intel是去年才正式进入这个战场的(虽然Intel核显的历史也相当悠久了)。最初对于采用DirectX 9的老游戏,Intel可能也并不抱持专门做支持的态度。

所以此前Intel对于DirectX 9老游戏,是基于微软D3D9On12这个中间转换层来实现向前兼容的。换句话说,游戏经过这一层再跑在玩家电脑上,必然存在性能折损。很不幸的是,目前仍然有一些DirectX 9游戏活跃在市面上,最典型的如《CS:GO》《英雄联盟》。Arc显卡此前反馈不佳的一个重要原因,就在于在老游戏上的性能表现不好。

我个人一直觉得,Intel的这种策略没什么大问题。从商业角度考虑,再花人力物力在老生态上,投入产出是不成正比的。对英伟达和AMD来说,DirectX 9就是他们一路走来的时代构成,当年的DirectX 9支持是顺理成章的。但对Intel这个新入市者而言,DirectX 9属于旧物:把注意力放到最新的DirectX 12和新技术上才是当务之急。

但在最新的4091新版驱动上,Intel重写了这部分驱动,开始对DirectX 9做原生支持。虽然不知道这个决定在Intel内部是如何达成的,但这对老游戏的体验提升必然有加成。

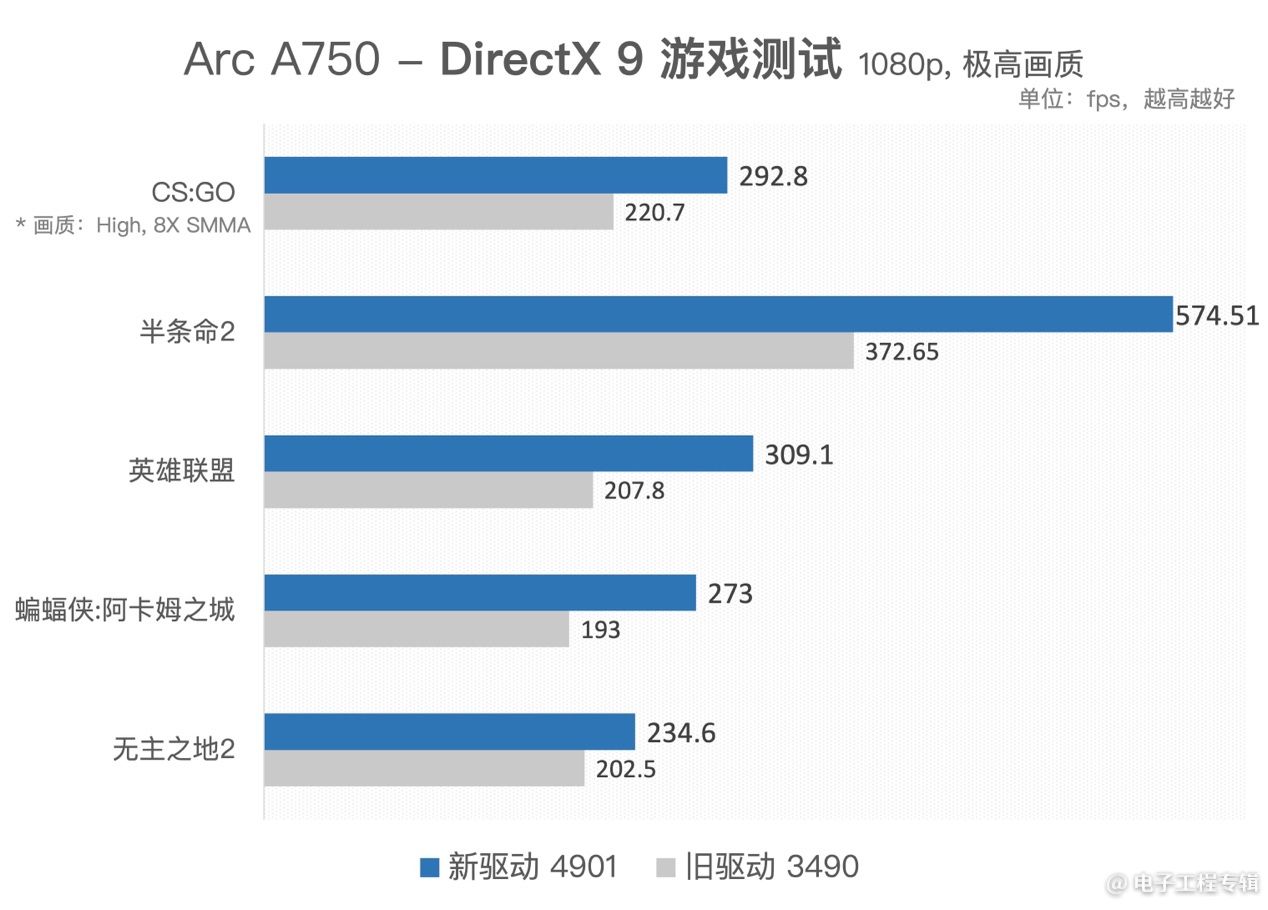

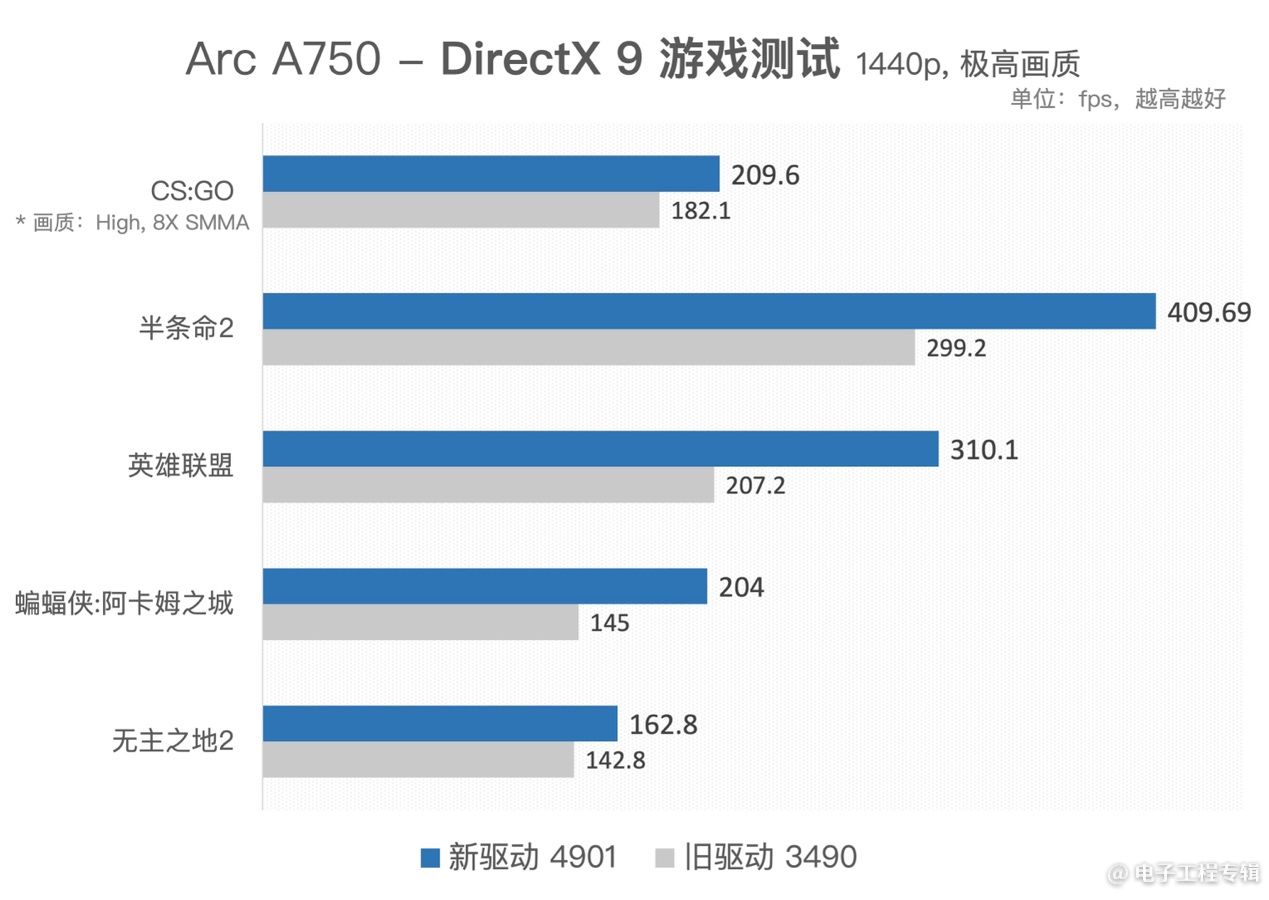

这次我们测了几款DirectX 9老游戏。所有测试若无特别说明,则表明画质设定在较高档。我们尽量选择一些自带benchmark程序的游戏,这样测得的结果更能反映真实情况。

其中《半条命2》原作虽然没有benchmark,但其资料片《半条命2:海岸线》中自带图形压力测试。而对于《CS:GO》《英雄联盟》这两个没有内置benchmark的游戏,我们分别采用HLTV和League of Graphs的赛事replay,加载到游戏中,以做测试变量控制——使用MSI Afterburner来记录平均帧。

得到的1080p及2k不同分辨率下的结果如下:

虽然部分游戏可能由于测试环境和测试内容的差异,并没有达到Intel官方宣称的提升幅度——《CS:GO》的提升幅度大约在33%左右。但整体还是给人留下了很深刻的印象。

尤其在1080p分辨率下,采用新驱动的Arc A750跑《半条命2》,比旧驱动性能高出了54%;《英雄联盟》也有大约50%的性能提升。这种幅度的提升,的确就是相当于买了块新显卡。

值得一提的是,因为时间关系,这次我们只记录了全程测试的平均帧,而没有记录1%低帧。实际上1%低帧在很多情况下,才是能够真正反映体验变化的考察维度。新驱动达成的1%低帧提升比平均帧的提升幅度显著更大。

比如说《英雄联盟》游戏,旧驱动下团战时的最低帧会下探到90fps,压力较大时的帧率徘徊在170fps左右;而升级新驱动以后,最低帧就达到了226fps,多人团战帧率在270fps左右。最低帧提升了2倍以上,低帧区间提升幅度将近60%。这对竞技游戏来说,价值还是很大的。

我们测试的样本数量可能还是太少,不过《蝙蝠侠:阿卡姆之城》和《无主之地2》都并非Intel官方在宣传时列出的游戏,但前者仍然有41%的提升,后者提升幅度约15%。这部分表明了DirectX 9相关的驱动部分重构,对大部分老游戏都带来了很大的价值。

作为一个已经没有多少时间来玩游戏的社会工作者,我个人仍然对于Intel最终重构驱动的做法感到意外。因为实际上很多DirectX 9游戏,现在甚至需要通过某些奇技淫巧才能跑在最新的操作系统上(比如我们这次本来打算测试的《孤岛惊魂2》)。这样的投入应该还是挺累的。

从我们过去的测试来看,对于比较新的DirectX 12和Vulkan游戏,同定位下Arc显卡和英伟达GeForce显卡表现是差不多的(虽然就GPU的面积效益而言,Intel仍处于弱势)。这也是Intel此前驱动工作的重点。这对刚刚入市没多久的市场参与者而言,其实已经挺不容易的了。

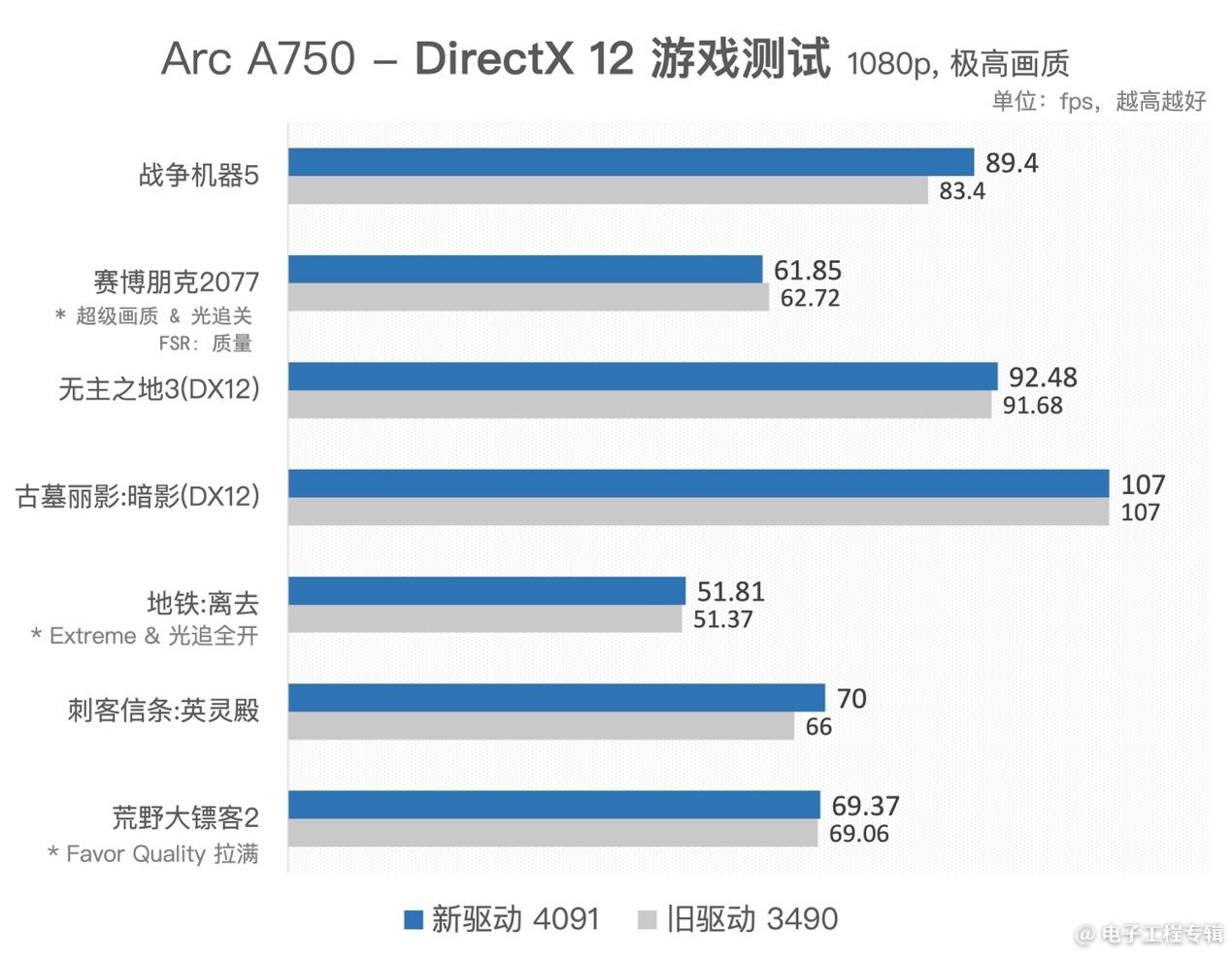

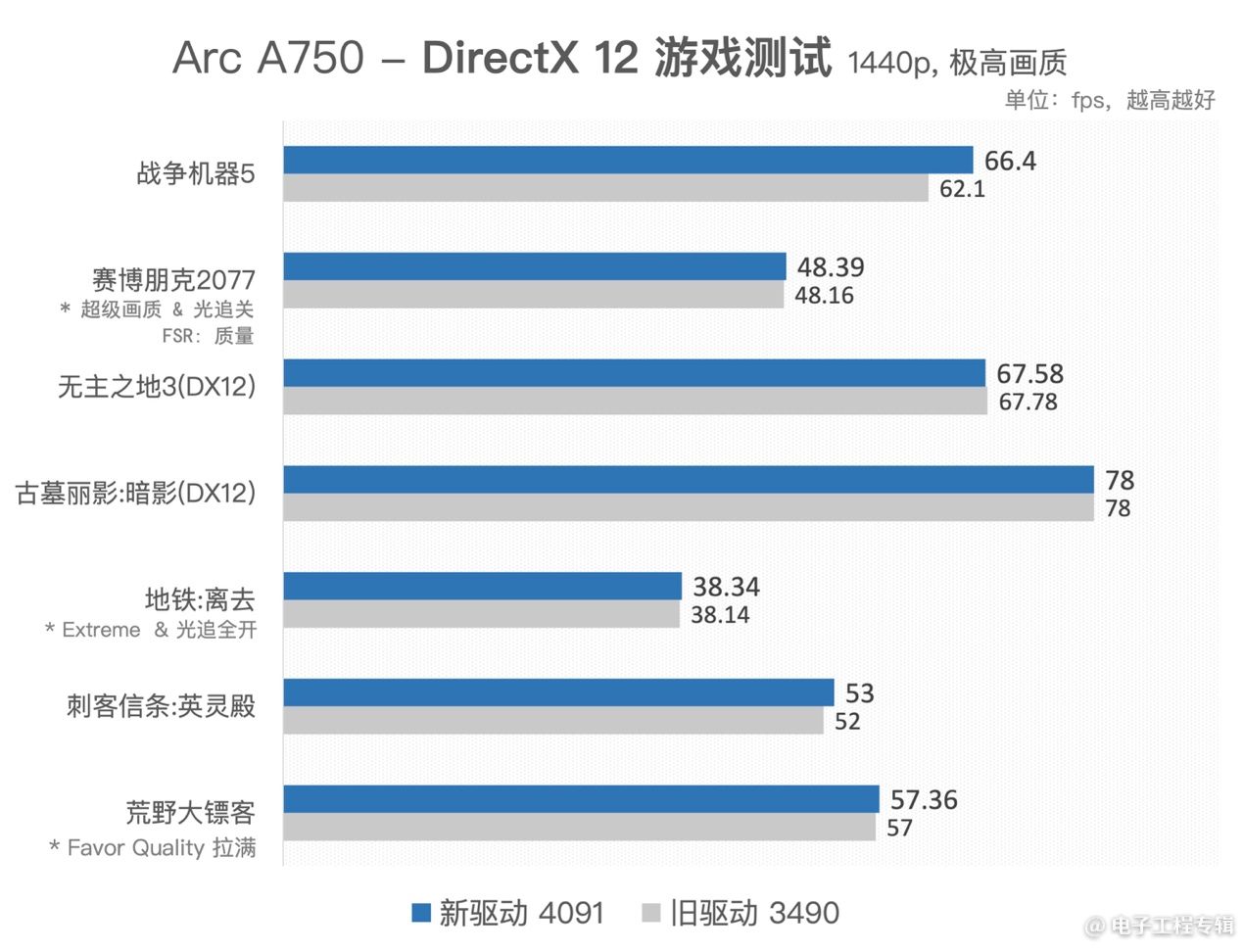

这次我们也测了一些DirectX 12和DirectX 11游戏大作,得到结果如下:

DirectX 12游戏测试结果,新旧版本驱动的变化并不大。部分游戏会有少量提升(如《战争机器5(Gear 5)》。毕竟这部分的表现,就这一代Alchemist架构而言,驱动所能达到的性能水平已经比较理想,提升空间就会相对有限。

这部分数据也给各位同学提供A750这张卡所在的量级水平参考:在应对部分比较主流的3A游戏时,Arc A750大致能够提供什么样的流畅度水平。这张卡应对主流3A游戏,问题是不大的;某些游戏开2k分辨率也可以达成比较理想的游戏体验。

不过我感觉,部分游戏未来还是有体验的提升空间的。比如《刺客信条:英灵殿》,不知是否因为显存分配问题,在2k分辨率下,这个游戏在部分场景下(如画面中出现大面积的水面)存在帧率显著下降的情况,但有时又会恢复到正常状态。未来应该有进一步的驱动提升空间。

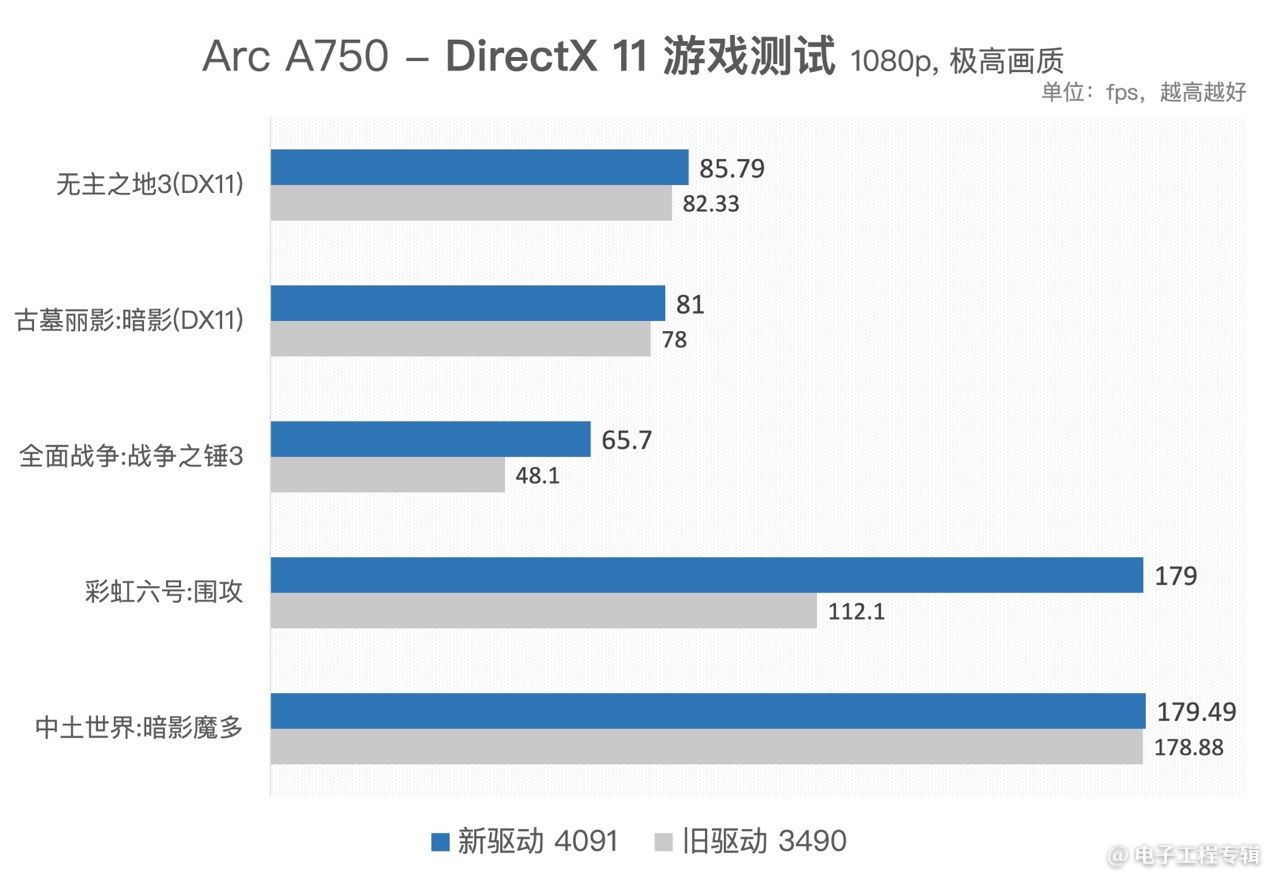

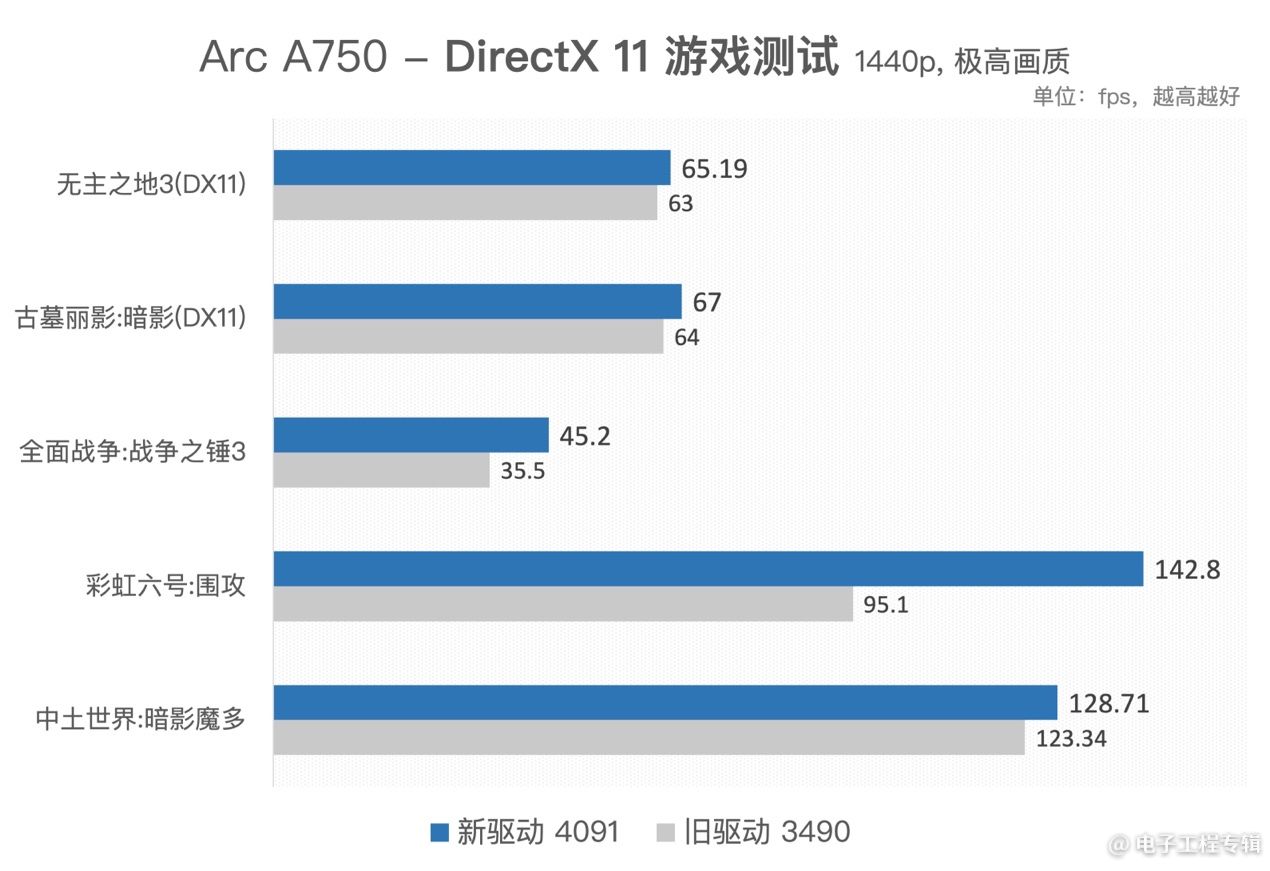

另外我们还做了一些DirectX 11游戏测试:

这里的很多DirectX 11游戏也都是老游戏了(我们每次给出《古墓丽影:暗影》和《中土世界:暗影魔多》的数据,是便于各位同学做跨平台对比)。像《彩虹六号:围攻》这样的游戏里,新版驱动也有高达60%的性能提升,可见新驱动对DirectX 11也有加成。

我在Arc A380的评测中还说过对于《全面战争:战争之锤3》这个游戏,Intel的早期驱动是存在贴图和光影错误的。后续的驱动很快修复了bug,4091则在效率上有了平均37%的提升,情况还是很理想的。可见这几个月,Intel的驱动团队加班应该很严重…(不是

其实在4091新驱动发布的媒体会上,Intel基本没怎么去提DirectX 11。这部分的驱动效率改进应该也有比较大的个体差异,我们测试的样本量还是小了。

另外,不知何原因我们测得的大部分结果,1080p分辨率下游戏性能提升都高于2k分辨率——这和Intel名列前茅方给的参考值不同。这可能和我们搭建的测试平台有关(怀疑问题出在主板上)。实际上Intel给出的2k分辨率游戏性能提升幅度更大的结果,可能才是更合理的。

Intel的这一代GPU架构存在越高分辨率、高并行度下,结果相比竞品更理想的情况。Xe-HPG架构一个Xe核心内有16个矢量引擎,每两个共享一个发射端口,用于访问存储子系统。如此一来,L1 cache需要对来自8个发射端口的请求做仲裁,每个端口又要在两个矢量引擎间做仲裁。

当然load/store系统具体是怎么做的,我们都不清楚。不过OneAPI的优化指南中提到其load/store系统以轮询的方式服务于矢量引擎。那么这种架构有一定概率造成低占用情况下,带宽很难吃满的状况。所以更高的2k分辨率对于Arc GPU而言会更理想一些。所以我们看到,在很多DirectX 12/11游戏里,Arc A750在2k分辨率下的游戏性能更容易超过RTX 3060。驱动更新可能也不会改变这种情况。

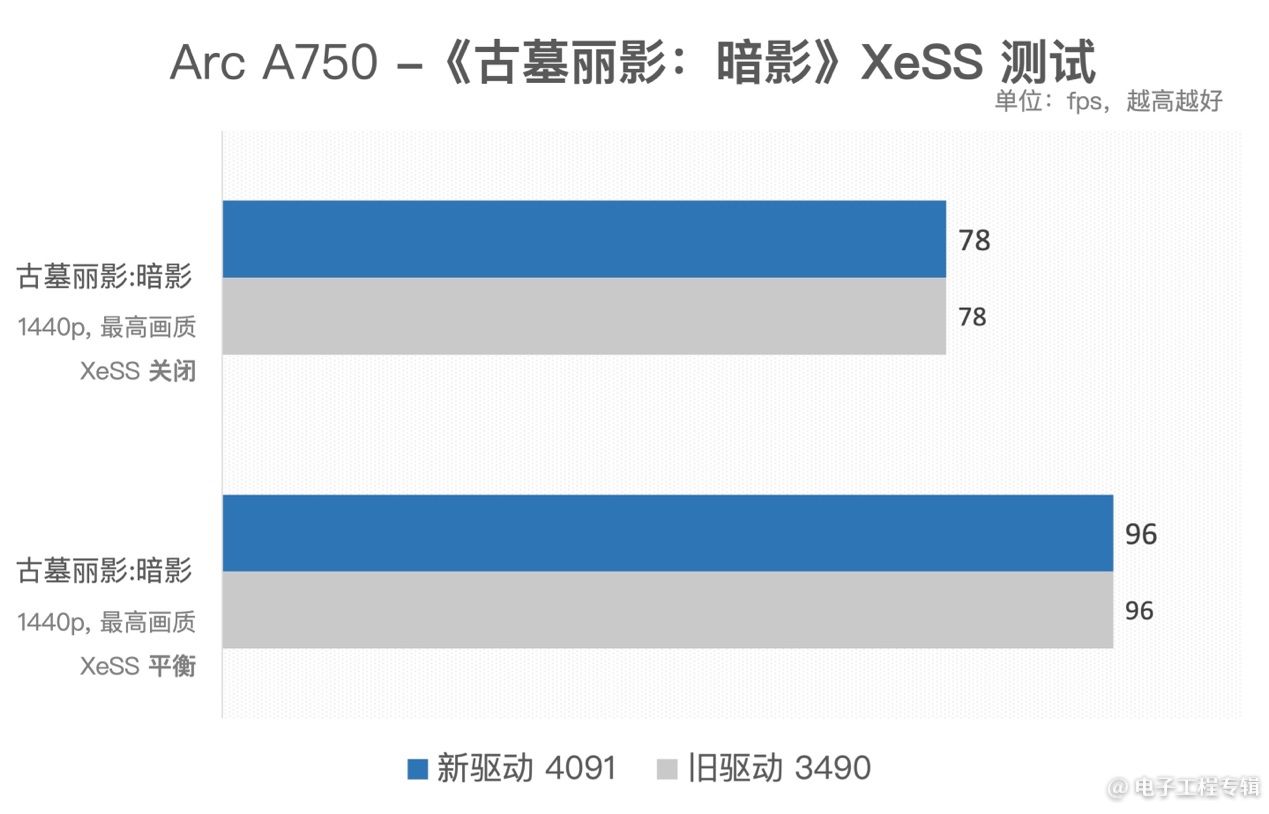

最后我们还简单跑了一下新驱动对于光追、XeSS的支持是否有加强。结果是,4091应该并没有在这两方面做调整。

先说说XeSS,也就是Intel的AI超分方案。现在3DMark里面有个专门做XeSS的跑分项目,能够给出开启XeSS后的帧率提升幅度,以及提供原生画质与AI超分画质的肉眼对比。不过其实到目前为止,AI超分似乎都还没有可量化的测试指标。所以要说XeSS究竟比起DLSS如何,似乎还很难有个确切的说法。

《古墓丽影:暗影》是支持XeSS的游戏之一。开启XeSS平衡档以后,2k全高画质下,帧率会有23%的提升。不过新旧驱动这方面是一模一样的。

但这个数据也算是给出了一个大致的参考。3DMark测试中,XeSS测试能够达成将近50%的帧率提升,两个驱动版本的情况也一致。这个技术的未来,对于Intel而言是至关重要的;现在发展的关键也是生态。

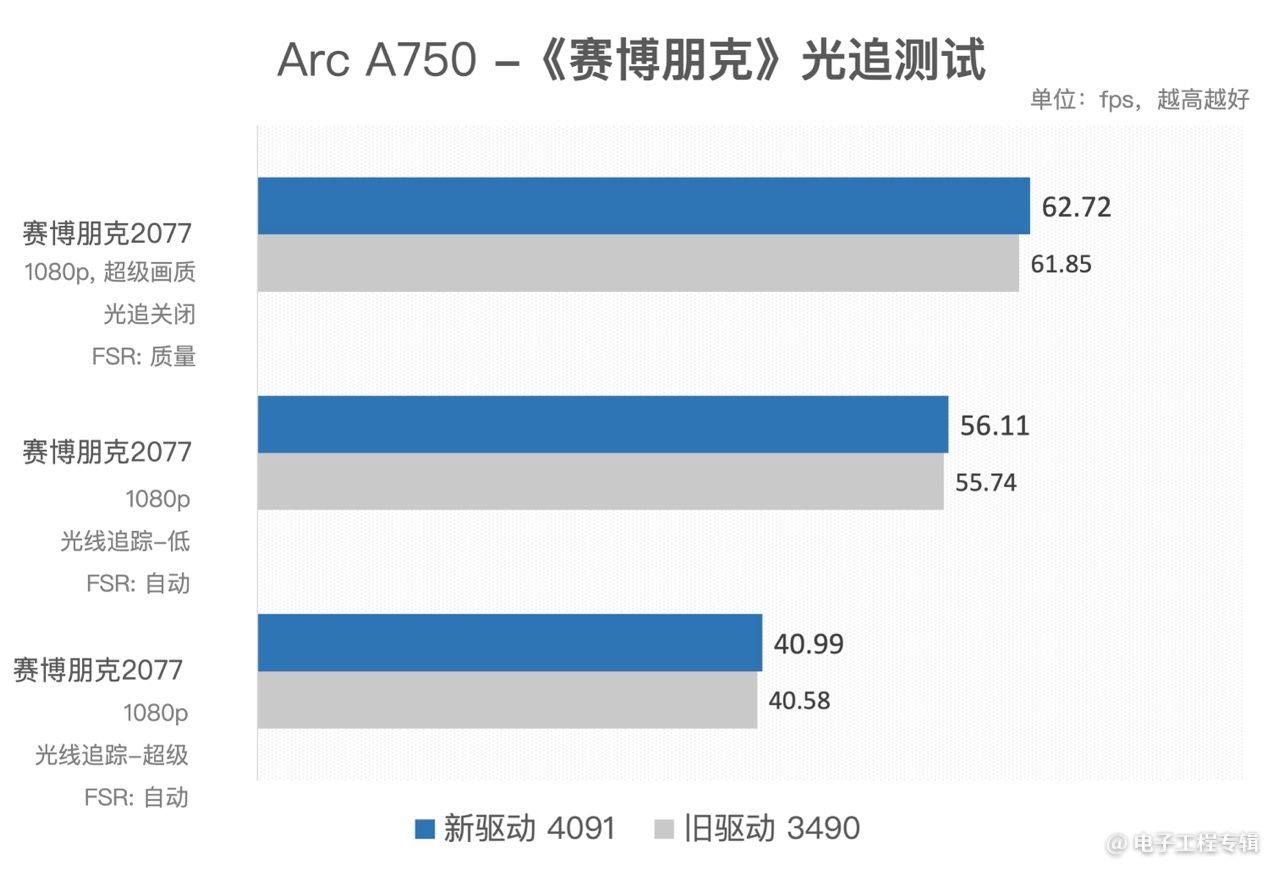

光追方面,用《赛博朋克2077》来做测试。值得一提的是,这个游戏也内置了AMD FSR选项(一种非AI的超分方案)。在选择游戏画质档位时,FSR会自动开启。比如在关闭光追的超级画质下,系统会选择FSR“质量”档;而在开启光追后,系统会选择FSR“自动”档。

FSR对于帧率也是有影响的。在我们的测试里,FSR质量档对这个游戏的帧率会有15%左右的加成。岔题了,新旧驱动版本在光追方面没有变化——也给有意愿买显卡的各位玩家做帧率数字上面的具体参考。要用Arc A750和包括RTX 3060在内的同档显卡,开光追畅玩《赛博朋克2077》还是需要一些画质设定子项方面的技巧。

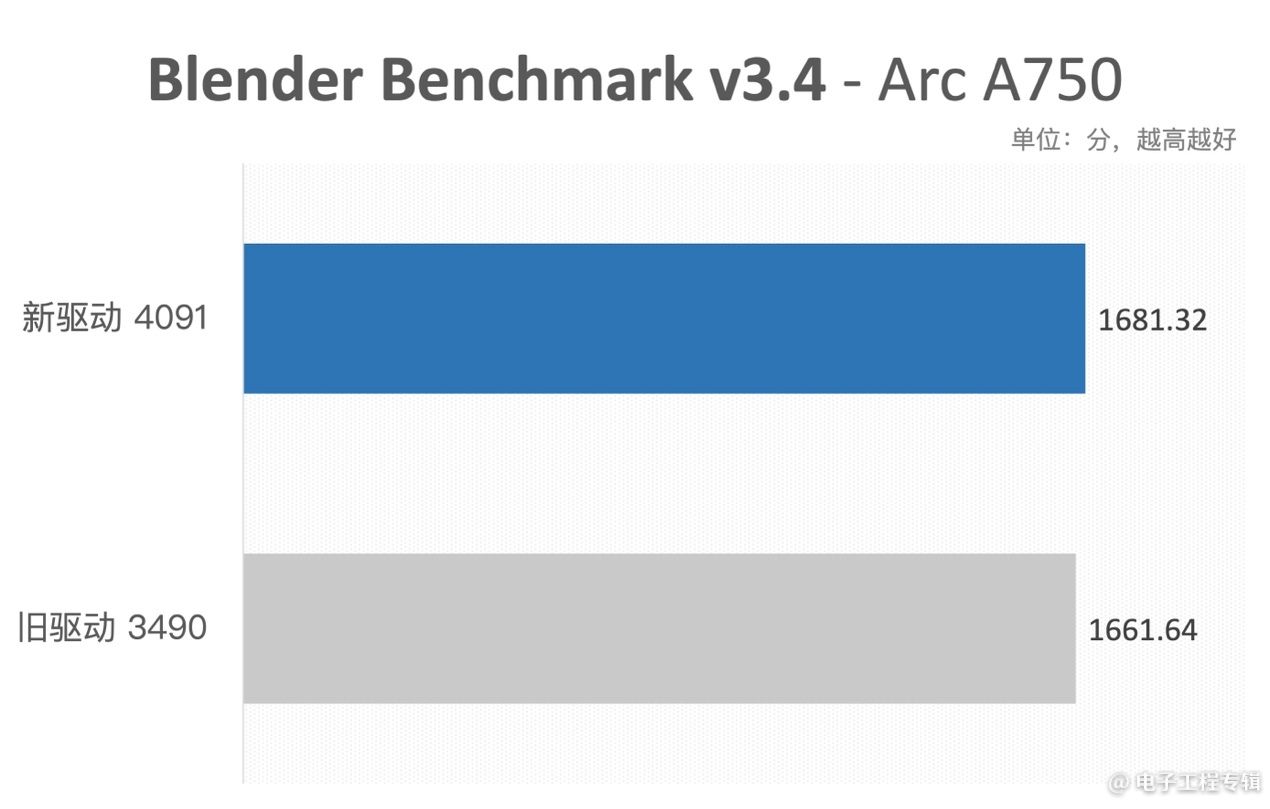

最后是通用加速方面的。有同学可能会好奇,为什么会有PCMark 10现代办公测试。实际上PCMark现代办公测试子项中,上表列出的这5个项目,是有GPU的显著参与的。尤其后面三项:照片编辑、视频编辑、渲染与视觉。而且从测试结果来看,Arc GPU的介入也比较积极。

另外Blender渲染也是现在GPU加速测试的热门。但从这两项来看,新旧驱动变化应该也不大;除了在PCMark 10的照片编辑项目中,新驱动有大约10%+的提升。

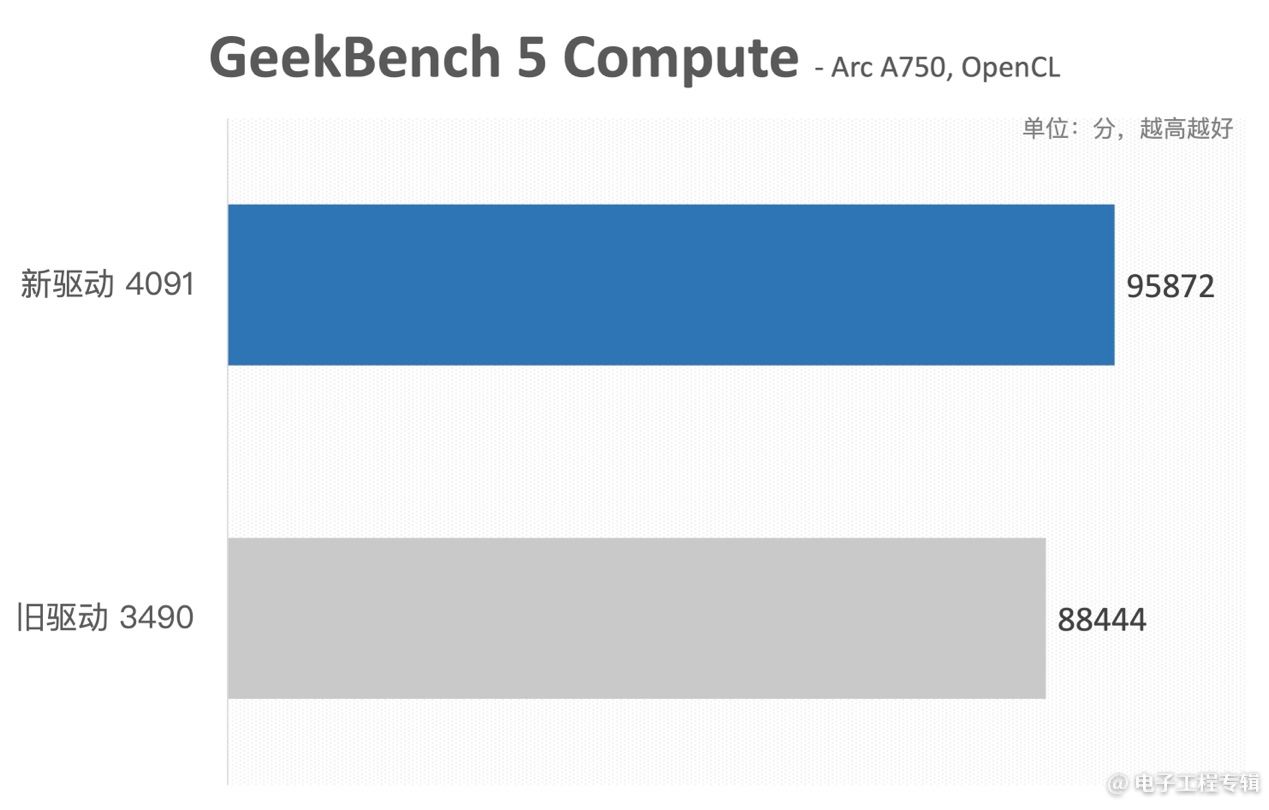

Geekbench 5的GPU OpenCL加速测试里,新驱动有8%的提升(之所以没有给Vulkan的结果,是因为不知何原因,Vulkan加速的测试结果浮动非常大)。因为时间限制,我们没有去探究具体提升在哪些方面。后续有机会我们也会对Arc显卡的通用加速性能做进一步的研究。这些数字也就给各位同学提供数据量级的参考依据吧。

Arc A750是去年10月才发布的,到现在也就4个月的时间。Q1’23 Arc Update(4091)这个驱动大版本的发布,除了能够看到Intel显卡团队一直在加班(…),就是Arc GPU的确是在一步步向前迈进,做生态扩展和效率完善的。

其实4个月的时间就能有可用性和体验上的飞跃,就新晋市场参与者而言是能够给消费者和投资者莫大信心的。伴随4091一起来的还有A750的降价,基本是“两手抓”实现了性价比的攀升。如果说去年体验Arc显卡,还要说一句“多多支持”的话,那么对于游戏爱好者而言,现在购入A750显然就有相当充分的理由了。

文章来自:https://www.eet-china.com/