市场对于数据的需求是无止境的,哪怕是一些增长已经开始放缓的市场,对数据的需求依旧是上升的。更不要提当下非常火爆的ChatGPT等人工智能相关的应用程序,它们的增长速度和对数据的需求更是十分惊人,例如ChatGPT-3就是以1750 亿个参数在进行训练。这些人工智能应用的快速发展,对处理器与带宽提出了更高的要求和标准。

“一直以来,业界始终存在着一个非常重要的误区,就是尽管算力的增长非常显著,但带宽上的进步却无法改善。也就是说,在现有高算力的基础之上,很多GPU资源并没有得到充分利用,从而造成了现在的困境。”Rambus IP核产品营销高级总监Frank Ferro说。

Rambus IP核产品营销高级总监Frank Ferro

AI应用由两类任务组成:训练和推理,每类任务都有自己的要求——训练需要录入大量数据来进行分析,属于大算力、高耗时场景;推理层对算力的需求会有大幅下降,但对成本和功耗更加敏感。随着AI推理越来越多地向边缘设备进行集成和转移,我们会把数据传输量大幅减少、边缘设备性能提升、延迟下降等优势迁移到边缘端,在这一过程中,凭借高带宽和低时延的特性,GDDR开始崭露头角。

众所周知,GDDR内存最初是为了满足游戏机和PC的高性能图形计算需求而开发的,但现在越来越多的出现在了数据中心和网络应用中,Frank Ferro认为,GDDR的应用依旧会在整个图形领域继续获得良好的发展,但之所以会出现这样的转变,是因为GDDR有着优异的数据传输速率,适用于很多边缘侧AI推理场景和网络应用。相比之下,如果选用DDR设备,无论是数量、成本还是功耗,都会面临巨大挑战。

以DDR4为例,尽管它的成本相对较低,但3.2Gb/s的运行速度也“令人抓狂”,而GDDR几年前就已经能够实现16Gb/s的带宽,是DDR4的3-4倍。此外,两者在容量密度、功耗等方面也存在着显著差异。所以,简单而言,如果将带宽视作主要标准和最重要的衡量因素,GDDR毫无疑问是较好的选择;但如果从存储密度和成本敏感性角度来看,DDR是更好的选择。

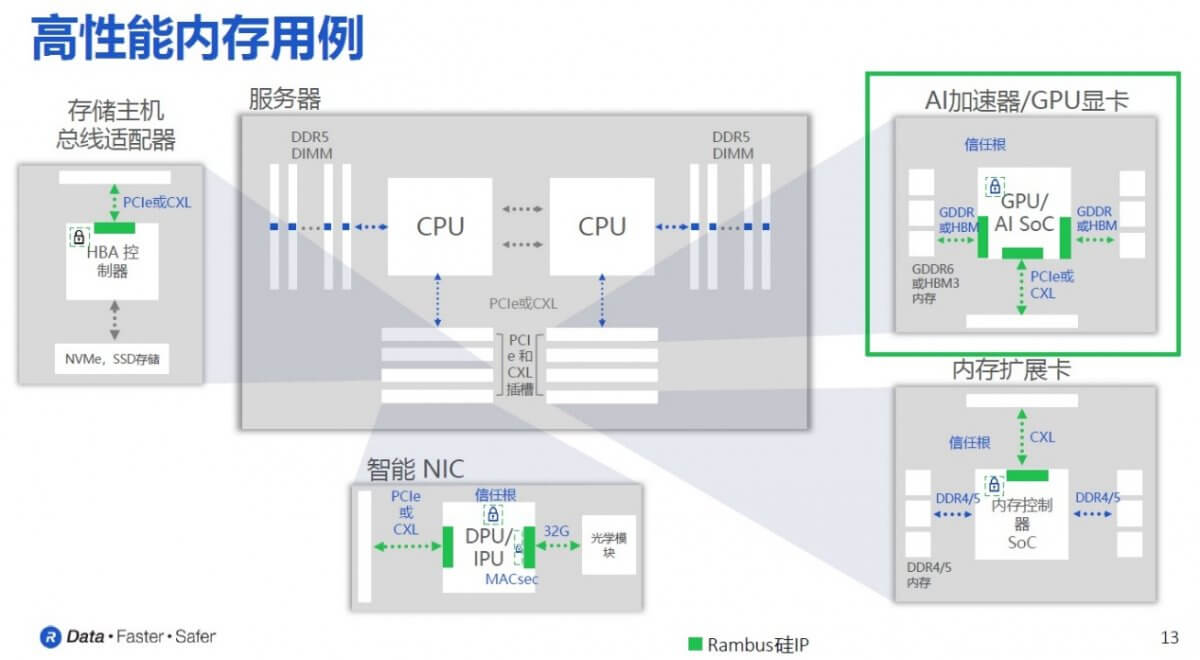

GDDR6在加速器上的高性能内存用例

在谈及HBM和GDDR6的应用差异时,Frank Ferro说如果把HBM用在AI推理上,尽管HBM能够提供800Gb带宽,但它超过了AI推理本身所需要的400-500Gb带宽,而且会使成本增加3-4倍,更适合AI训练这种需要更大带宽和更低延迟的应用场景。对于需要更大容量、更高带宽的AI推理场景,GDDR6是更合适的选择。

他同时否认了Rambus会开发GDDR6X相关技术或产品的说法。“GDDR6和GDDR6X都是行业非常优异的技术,性能都可以达到非常高的水平,但前者是JEDEC标准,后者现在还是专利保护的技术,更多是以具体的客户需求为导向,这并不符合我们的初衷。”Frank Ferro强调说。

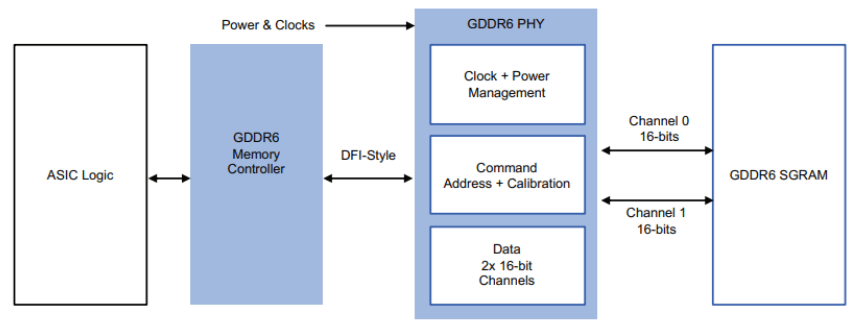

为了能够向人工智能/机器学习(AI/ML)、图形和网络应用提供高成本效益、高带宽的内存性能,Rambus公司日前宣布推出24Gb/s GDDR6 PHY产品,能够为每个GDDR6内存设备带来96GB/s的带宽。除此之外,Rambus GDDR6 PHY还经过了全方位的优化,并可与Rambus GDDR6数字控制器IP相结合,形成完整的GDDR6内存接口子系统解决方案。

Frank Ferro将Rambus GDDR6 PHY IP的主要特点归结为以下五个方面:

在实际应用中,PHY物理层通过两个16位插槽与DRAM直接相连,另外一侧则是DFI接口与内存控制器进行连接,确保控制器直接接入整个系统的逻辑控制。之所以采用双读写通道,Frank Ferro解释说,进入GDDR6时代后,采用16位双读写通道已经成为趋势,32位的数据宽度能显著增加数据的传输速度和传输效率。同时,GDDR6内存还有8个这样的双读写通道,总共加起来可以实现256位的数据传输宽度,可以带来非常大的数据传输速率和系统效率提升,功耗管理上也可以获得进一步的优化。

此外,他还特别强调了clamshell模式——在该模式试下,每信道可支持两个GDDR6设备,从而使整个系统容量直接翻倍。“一般来说,AI推理应用对带宽的需求保持在200-500Gb/s范围内,而每一个GDDR6设备的带宽都可以达到96Gb/s,因此将4-5个GDDR6设备组合在一起,就可以轻松满足500Gb/s及以下的带宽需求。“Frank Ferro说。

文章来自:https://www.eet-china.com/