随着ChatGPT的火出圈,各类人工智能大模型和应用需求开始呈现爆发式增长。而为了支持这些应用的机器学习训练,需要大量人工智能处理器,目前这个领域是英伟达图形处理器(GPU)的天下。

知情人士透露,微软正与AMD合作共同自研人工智能处理器“雅典娜”(Athena),在合作中,微软为AMD提供了资金支持,并投入了上百名员工。这是微软多管齐下战略的一部分,目的是保障人工智能处理器芯片的供应,以实现对英伟达方案的替代。

微软既是云端运算服务的拔尖供应商,也是AI应用的推动者。目前他们已向ChatGP母公司OpenAI注入上百亿美元,并将其集成到 Bing 搜索引擎和 Microsoft Edge 网络浏览器中,微软还表示要在所有软件产品里增加此功能。

自研AI芯片是微软强化其相关业务的关键一环,据The Information报道,该芯片初代将采用台积电5nm工艺制造,较早将于明年开始用在公司内部和OpenAI,用于教育大型语言模型(也称为 LLM),以及在 LLM 培训期间和之后获取的任何数据。

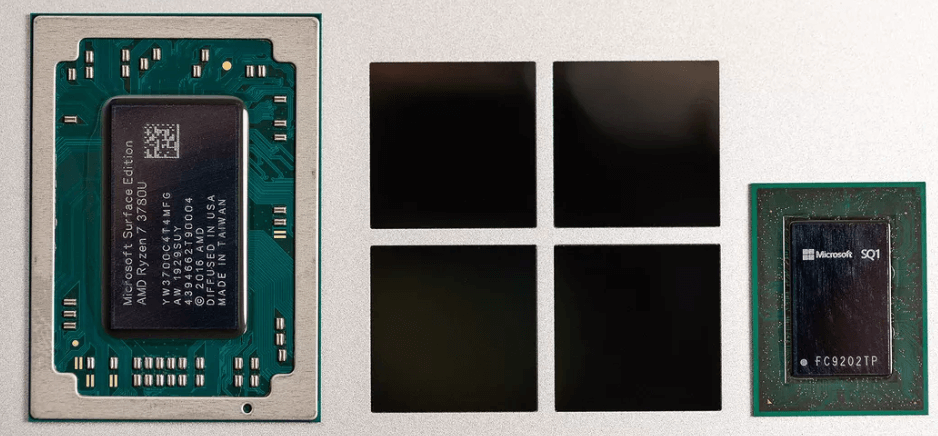

虽然此前微软也曾与AMD、高通(Qualcomm)合作开发定制Arm架构芯片,用于其 Surface Lap较好 和 Surface Pro X 设备的先例,但微软发言人Frank Shaw否认AMD是Athena计划的参与者:“AMD是很棒的合作伙伴,然而没参与Athena。”

微软与AMD合作定制的Ryzen Surface Edition处理器,以及与高通合作定制的 SQ1 处理器

受此消息影响,AMD股价周四上涨超过6.5%,微软股价上涨约1%。两家公司均拒绝对此消息置评。英伟达股价下跌1.9%。

不过,这并不预示微软要与英伟达分道扬镳,微软打算继续双方的紧密合作。目前英伟达芯片仍是训练和运行LLM的必要工具,是包括亚马逊AWS和谷歌云在内的许多生成式人工智能工具提供商的优选芯片供应商,特斯拉首席执行官埃隆·马斯克(Elon Musk)也为自己的人工智能业务囤积了数千个英伟达处理器。

英伟达GPU近段时间以来的供不应求,也凸显出微软和其他开展人工智能业务企业面临的急迫供应短缺。

因为微软与OpenAI的关系,以及它自己新推出的AI服务,例如新版会聊天的Bing和经AI强化的Office工具,要求的计算能力超出当初订购芯片和建立数据中心的预期。微软也在更新老产品,如GitHub的代码生成工具。这些AI程序全都在微软Azure云端运行,需要英伟达价格昂贵且功能强大的处理器。

但这同时也是AMD的战略重点领域。本周二(5月2日)AMD CEO苏姿丰在财报电话会议上表示,“我们对自身在人工智能领域的机遇感到非常兴奋,这也是我们的较高战略优先级。我们正处于人工智能计算时代非常初期的阶段,人工智能的普及率和增长速度比最近历史上的任何其他技术都要快。”

苏姿丰还强调,AMD将有机会为大客户制作部分定制芯片,用于他们的AI数据中心。

微软对芯片行业的参与正在逐步深入。过去几年,在英特尔前高管拉尼·博尔卡(Rani Borkar)的带领下,微软正在建设一个芯片部门,目前已经拥有近1000名员工。而除了开发用于服务器和Surface电脑的芯片之外,早在2019年,该团队就开始秘密研发内部代号为“Athena”的AI芯片,目前这个团队人数已经超过300人,投入超过20亿美元。

The Information引述的消息来源称,微软已经提供一小部分芯片原型给内部和OpenAI员工使用,以测试在GPT-4 等最新大语言模型的表现。不过即使该项目按照时间表顺利推进,名列前茅个版本也只是个起点。设计生产出一款强大的芯片需要数年时间,而英伟达拥有很大的名列前茅优势。

除了芯片本身,英伟达还围绕这些芯片还提供了一整套配套的软硬件,包括芯片、编程语言、网络设备和服务器,从而让客户可以快速搭建自己的能力。

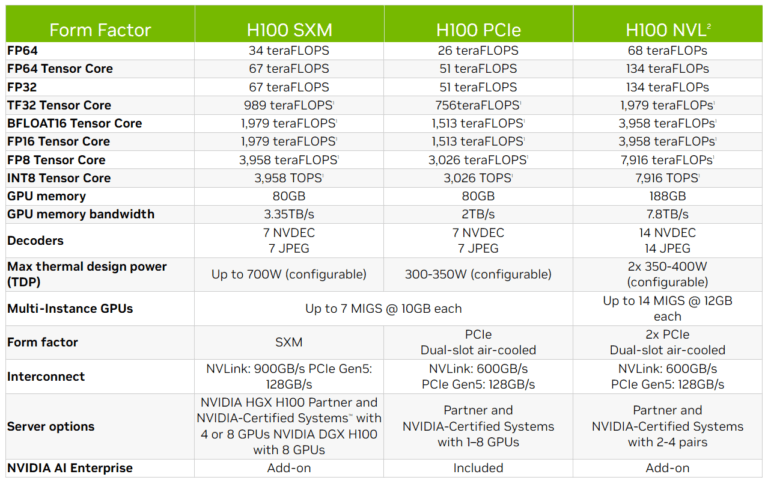

SemiAnalysis的分析师迪伦・帕特尔(Dylan Patel)表示,开发类似于雅典娜的芯片可能每年需要花费1亿美元左右,ChatGPT每天的运营成本约70万美元,大部分成本来源于昂贵的服务器处理器。据估计,OpenAI 将需要超过 30,000 个 Nvidia 的 A100 GPU 来实现 ChatGPT 的商业化,目前英伟达 最新的 H100 GPU 在 eBay 上的售价超过 40,000 美元。如果雅典娜芯片与英伟达的产品拥有同等竞争力,每个芯片的成本将可以降低三分之一。

英伟达最新的 H100 NVL GPU 将于今年下半年推出,非常适合大规模部署 ChatGPT 等大型 LLM。与数据中心规模的上一代 A100 相比,具有 94GB 内存和 Transformer Engine 加速功能的全新 H100 NVL 在 GPT-3 上提供高达 12 倍的推理性能。

对于ChatGPT每天70万美元的运营成本计算方法,今年2月9日,SemiAnalysis发布的具体报告显示,2022年谷歌在搜索业务的收入为1624.5亿美元,每次查询的平均收入为 1.61 美分,谷歌服务业务部门的营业利润率为 34.15%,则算下来每次谷歌查询的成本为 1.06 美分,以OpenAI使用的1750亿个参数的GPT-3大语言模型作为计算,OpenAI每天的运营成本为 69.4444万美元,每天拥有1300万的活跃用户,每个用户响应15次,这样估算下来ChatGPT每次查询成本为0.36美分。

另外值得一提的是,天下苦英伟达久矣,已经有多家公司在研发或推出对标其芯片的产品,亚马逊、谷歌和 Facebook 等科技巨头目前也在为人工智能制造自己的芯片。

文章来自:https://www.eet-china.com/