人工智能的发展与芯片的发展息息相关,从简单的BP神经网络到如今的百亿参数大模型,从结构化场景下的模式识别到AR/VR、元宇宙等终端应用,再到如今的GPT人机交互,每一次大的AI技术革命的背后都是算力的革命。

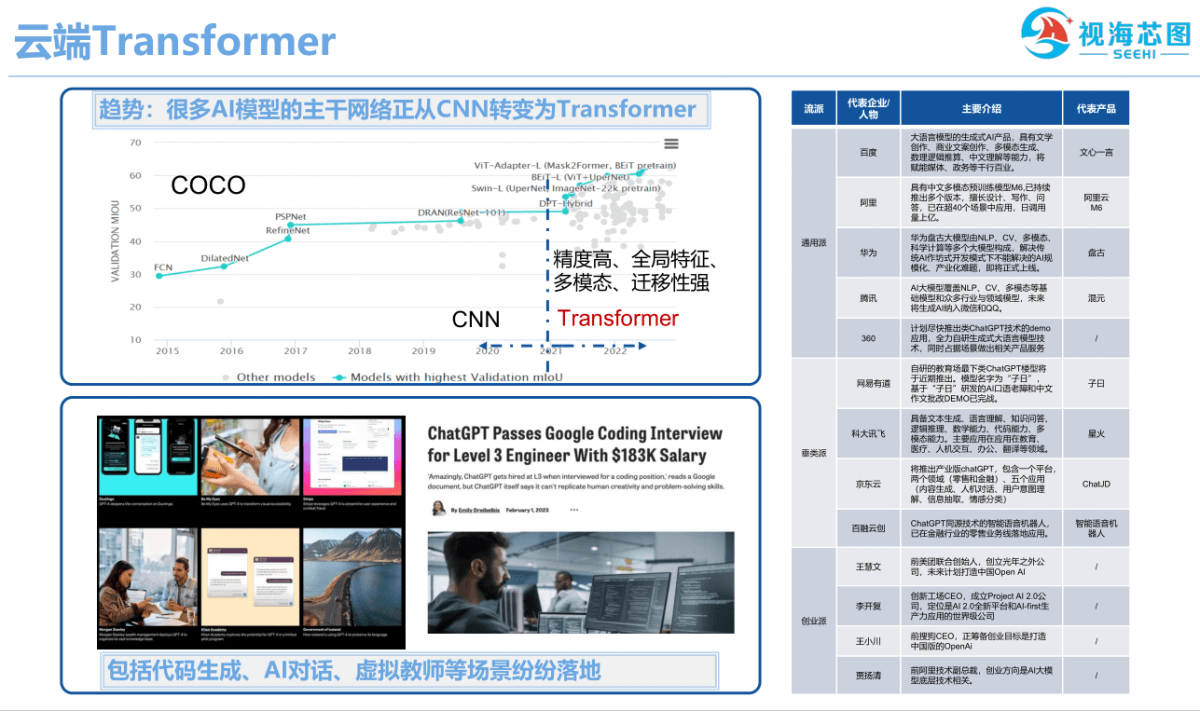

近几年Transformer大有取代CNN之势,因为它可以获取全局特征,有一定的知识迁移性,能够很好地适应各种场景。在COCO榜单上基本处于霸榜状态,CNN为主的框架很多已经切换到Transformer。而当前的算力革命DRAM存算技术,是Transformer是否能自顶而下,普遍进入广泛AI应用领域的关键。

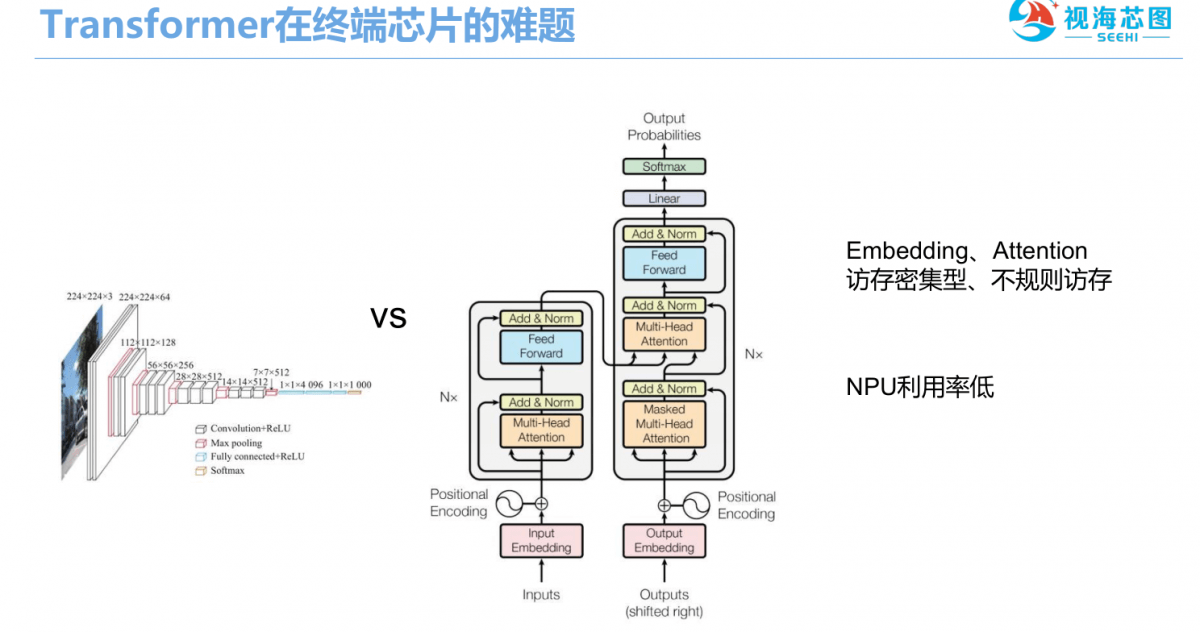

在硬件支撑方面,终端产品不能通过Transformer来做,必须依赖支撑人工智能加速的NPU。而现有大部分NPU面临的问题是,Transformer结构区别于传统的CNN以计算为核心的架构,Transformer更多是以数据为中心的架构,Embedding、Attention等都是访存密集型算子。

这样要么很难映射到NPU上面去,要么映射上去应用率很低,需要CPU配合。以GPT为例,其基础架构Transformer贴切大脑海马体,计算类型属于数据密集型,系统访存成为系统瓶颈,给芯片带来了巨大的挑战。

由此,DRAM存算技术应运而生,它结合了3D集成工艺和创新架构,可以有效克服系统访存瓶颈,实现加速Transformer,同时极大减低芯片功耗。在工艺上,3D集成可以把DRAM/内存和计算逻辑进行垂直互联,百倍提高数据互联带宽。在架构上,电路定制、模型并行和数据并行等多种技术可以围绕Transformer结构进行定向加速。

作为首批3D集成数字化芯片量产国内团队,成都视海芯图微电子有限公司已经在DRAM存算技术领域深耕多年并将持续推进内存墙和功耗墙的突破。

5月12日,第十三届“松山湖中国IC创新高峰论坛”在广东东莞松山湖凯酒店举行,本届论坛以“面向AR/VR/XR 与元宇宙的创新 IC 新品推介”为主题,通过组织本土芯片设计企业和终端应用厂商开展深度的需求对接,打造国内具影响力的中国创新集成电路新品集中推广和发布平台,对提升国内集成电路设计水平、推动促进国内芯片-整机联动发展具有积极意义。

视海芯图创始人、董事长许达文

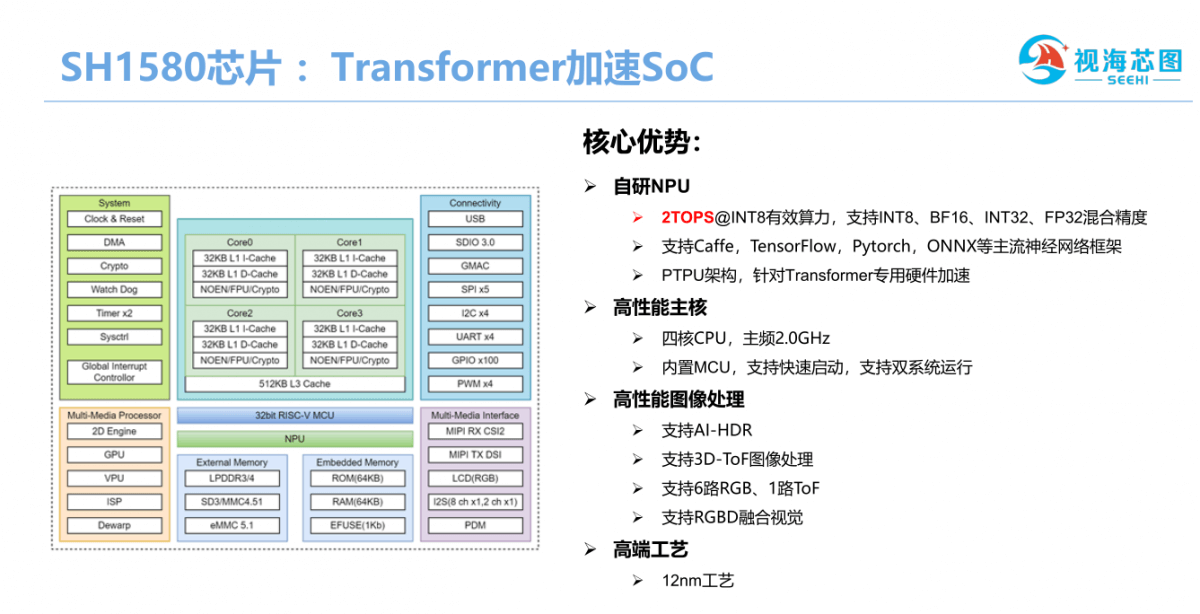

视海芯图创始人、董事长许达文在会上介绍了公司全新的Transformer加速SoC SH1580。这款高性能智能视觉SoC集成4亿晶体管,采用12nm工艺,自主设计了多态神经网络处理器(Polymorphic Tensor Processing Unit,PTPU)和3D视觉ISP,配备了4核Arm CPU A53。

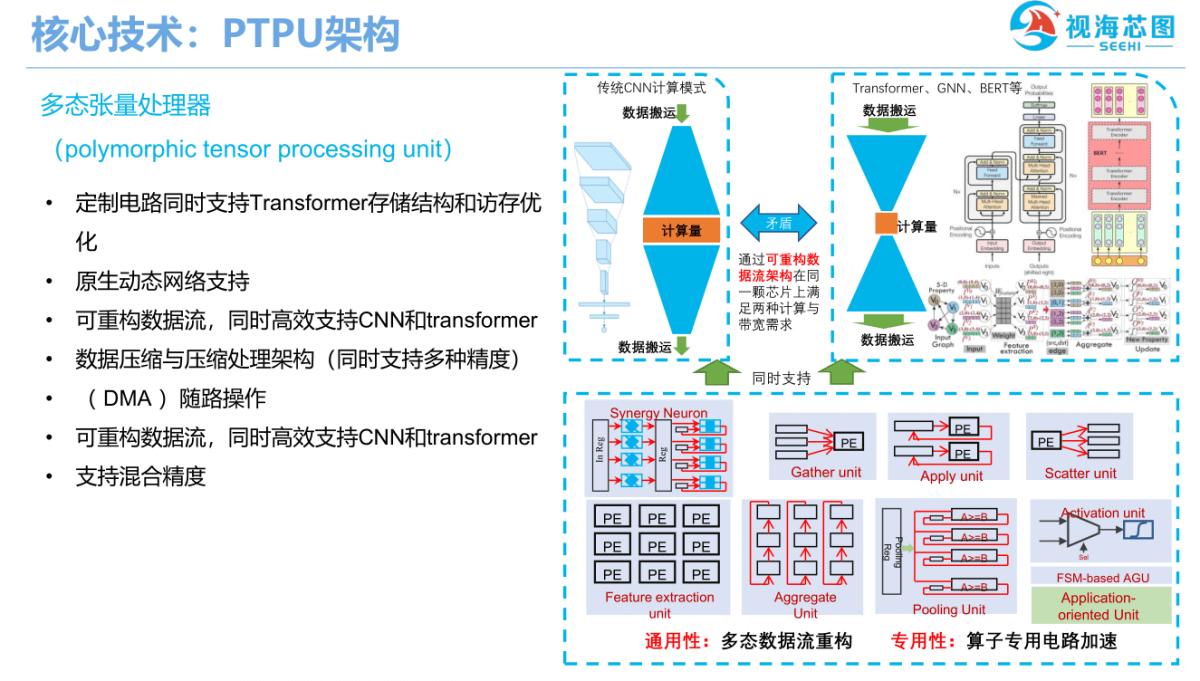

许达文表示,公司自主研发的多态神经网络处理器具备4 ToPS算力,不仅能支持善于提取局部特征的CNN,也对Transformer、Bert和点云神经网络等新兴AI模型有针对性加速效果。

“动态网络对Transformer是特别重要的支撑。由于需要兼顾两种架构,需要设计一个可重构的数据流来支持,因为两种架构的数据流通量是不一样的。”他说到。

据介绍,SH100采用多通道DDR,具备超高数据高带宽,针对新兴AI模型优化的片上存储模块设计,可以为片内计算阵列提供可重构的高速数据流,从而,让视频流AI处理、多模态数据融合和点云神经网络等在AIoT终端落地实现可能,在智能教育硬件、服务机器人和ADAS等领域具有重大潜力。

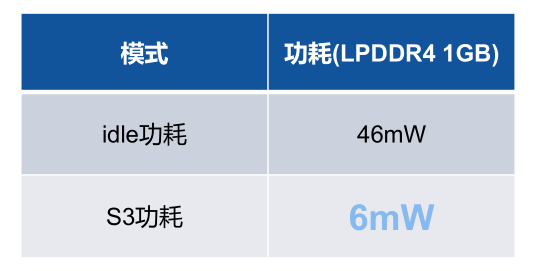

另外,SH100采用独立电源域芯片架构,控制不同模块上下电,支持软硬件协同优化,适合各种低功耗应用场景。

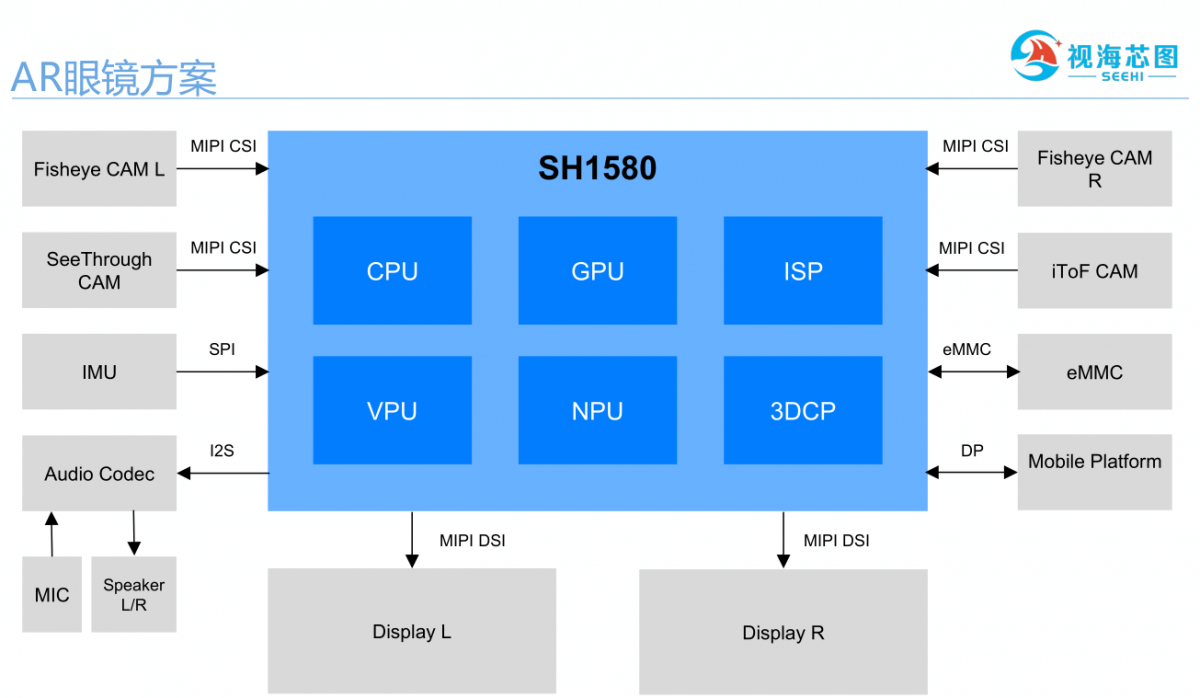

据介绍,视海芯图成立的名列前茅年就与一家AR眼镜公司签订了战略合作协议,很早就开始布局元宇宙。许达文以微软(Microsoft)的Hololens为例,其几个主要核心功能包括:

要实现这些功能,需要把数字信息准确映射到物理世界中,用到场景识别和物理识别,还要支持图像输入、云输入等混合型输入。特别是图像输入,往往既要接收2D图像,也接收3D图像。

这都需要复杂的配套场景和算法支撑,通常AR/VR终端产品公司很难做到。如果有一套基于Transformer为架构的模型,能够解决他们的问题,那一定非常受他们欢迎。

最后许达文介绍了视海芯图AR眼镜方案的一些重要功能,包括特征点匹配(Feature Matching)LoFTR的SLAM,地点识别(Place Recognition)的SVT—Net,语义分割识别(SegFormer)和三维重建(Point-Bert)等。

许达文简介

博士毕业于中国科学院计算技术研究所,期间赴加州大学圣芭芭拉分校(UCSB)博士联合培养。归国之后,分别在AMD中国研究院工作和高校任教,曾主持和负责国家自然科学基金项目,在Transaction on Computers、TCAD、TVLSI、ICCD、ICCAD等拔尖期刊和会议发表多篇论文,具备多次AI流片经验与创业经验,曾从事指纹芯片工作,次年销售额即达到两千万元,获昆山市创业领军人才,19年退出后指纹芯片公司,之后创办视海芯图。

关于视海芯图

近二十年处理器性能接近指数上升,内存DRAM发展跟不上,造成“存储墙”, 成立于2020年12月的视海芯图创新性使用DRAM存算技术进行神经网络运算和图像处理加速,解决其中的存储墙问题,实现超低功耗的算力芯片。

团队具有5nm和7nm高端工艺量产经验,还熟悉3D和异质集成的特殊工艺,目前与中国科学院计算技术研究所展开合作,获得舜宇光学、网易有道和虹软科技3家上市公司战略投资,已经与股东合作围绕IoT、元宇宙和车载方面的核心图像处理算法进行存算一体加速,研发领域通用芯片。公司已在北京、成都、杭州和新加坡建立研发中心,打造国际化高水准团队,持续推进DRAM存算技术,在内存墙和功耗墙方面不断突破,与合作伙伴一起进行存算一体芯片落地。

文章来自:https://www.eet-china.com/